Walter TydecksNeuronale Netze |

|

Beitrag für den Themenkreis Naturwissenschaft und Technik von 50plus aktiv an der Bergstraße am 28.10. und 4.11.2020 in Bensheim

Inhaltsverzeichnis

Einleitung

Zur Geschichte der Neuronalen Netze

Erregbarkeit träumender Nerven und des Immunsystems

Übertragung über das Nervensystem (Bahnen, Filz, Knäuel)

Unsicheres Wissen (Überwachtes und unüberwachtes Lernen)

Neues Paradigma der Wissenschaft?

Einleitung

Werden Computer dank neuronaler Netze lebendig und beginnen, uns nicht nur beim Denken und Rechnen, sondern auch im freien Spiel der Phantasie und sogar der Handlungsfähigkeit zu überholen? In diesem Beitrag geht es um zwei Thesen:

– Natürliche Neuronale Netze verfügen über eine »Datenschnittstelle« zu ihrer Umgebung, mit der sie unsicheres Wissen aufnehmen können. Sie befinden sich in einem träumenden Zustand, in dem sie nicht nur reflexartig nach festen Abläufen auf äußere Ereignisse reagieren, sondern sich zugleich in einem imaginären Möglichkeitsfeld bewegen, aus dem heraus sie kreativ gegenüber zuvor unbekannten Reizen handeln können.

– Im engeren Sinn werden die Künstlichen neuronalen Netze als Träger eines mehrschichtigen Lernens (dem Deep Learning) verstanden, das in der Regel von außen trainiert wird, bis es ein Wissen erwirbt, das weit über die Kapazitäten des menschlichen Gehirns hinausgeht. Mit welcher Intelligenz die Künstlichen Neuronalen Netze vorgehen, entzieht sich bisher weitgehend unserer Kenntnis, obwohl sie vom Menschen geschaffen und trainiert werden. Das macht sie so faszinierend und unheimlich. Es ist nicht einmal sicher, ob die Natur über ähnliche Verfahren verfügt, wie sie für Künstliche Neuronale Netze eingerichtet werden.

Die Theorie und die ersten Anwendungen neuronaler Netze sind in den 1940ern in einem ungewöhnlichen Diskussionsprozess mit Teilnehmern aus so verschiedenen Gebieten wie Neurophysiologie, Kybernetik, Ethnologie, Anthropologie, Psychologie, Soziologie bis hin zu Philosophie, Sprachforschung, Mathematik, Logik und Automatentheorie entstanden. Keine der beteiligten Wissenschaften ging unverändert aus diesen Gesprächen hervor. Dennoch gelang kein Durchbruch. Das ändert sich schlagartig, seit mit dem Internet, den Smartphones und den Sozialen Netzen unbegrenzt Trainingsdaten für neuronale Netze zur Verfügung stehen und die Kosten für unglaubliche Rechnerleistungen weiter gefallen und finanzierbar geworden sind. Seither erleben die Neuronalen Netze eine Wiederkehr und bestimmen zunehmend unseren Alltag.

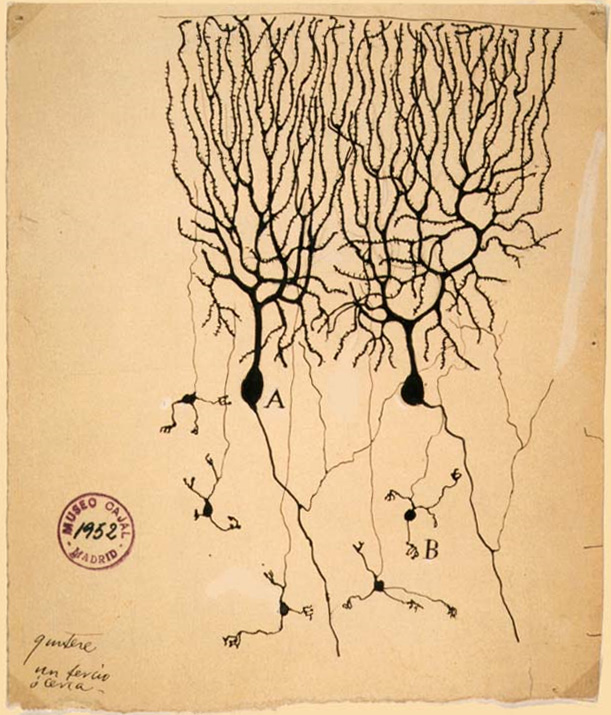

Zur Geschichte der Neuronalen Netze

– Seit 1870 untersuchte der italienische Arzt Camillo Golgi (1843-1926) das Feingewebe des Nervensystems und wies die Netzstruktur im Gehirn nach. Santiago Ramón y Cajal (1852-1934) zeichnete die Netze und entwickelte »die These, dass das Nervensystem aus einzelnen Nervenzellen besteht, den Neuronen, wie sie von dem deutschen Anatomen Waldeyer 1891 erstmals benannt wurden« (Spitzer, 3). Von ihm stammen die ersten Diagramme von Sinnesorganen und den von ihnen ausgehenden Nervenbahnen, die er aus gründlichen Untersuchungen des Nervensystems und dem Sezieren von Fröschen und anderen Tieren gewonnen hatte. Der Mediziner, Psychiater und Psychoanalytiker Lawrence Kubie (1896-1973) beschrieb an ihrem Beispiel 1930-41 erstmals Schaltkreise, geschlossene Nachhall-Kreise (closed reverberating circuits), um das Gedächtnis zu verstehen.

–1943 veröffentlichten Warren McCulloch (1898-1969) und Walter Pitts (1923-1969) A logical calculus of the ideas immanent in nervous activity. Sie führten das Neuron »als logisches Schwellwert-Element mit mehreren Eingängen und einem einzigen Ausgang in die Informatik ein« (Wikipedia über Perzeptron) und begründeten damit die Untersuchungen neuronaler Netze. »McCulloch und Pitts zeigten, dass ein hinreichend großes Netzwerk von derartigen einfachen Neuronen in der Lage ist, jede beliebige Klassifizierung beliebiger Eingabemuster darzustellen.« (Spies, 261)

– 1949 stellte Donald Hebb (1904-1985) die nach ihm benannte Hebbsche Lernregel auf, »dass immer dann, wenn zwei miteinander verbundene Neuronen gleichzeitig aktiv sind, die Verbindung zwischen ihnen stärker wird« (Spitzer, 44). »Hebb gilt damit als der Entdecker des Modells der synaptischen Plastizität, welche die neurophysiologische Grundlage von Lernen und Gedächtnis darstellt.« (Wikipedia) »Damit ließen sich Grundtatsachen der Verhaltensforschung wie etwa das Konditionieren von Reflexen auf bestimmte wahrgenommene Muster mit Hilfe neuronaler Netzwerke formal nachbilden.« (Spies, 261)

– 1958 führt Frank Rosenblatt (1928-1971) das Perzeptron ein: das erste, einfache Künstliche Neuronale Netz, dessen Grundidee allen bis heute entstandenen Künstlichen Neuronalen Netzen zugrunde liegt. Er geriet jedoch in Konflikt mit dem seinerzeit führenden KI-Forscher Marvin Minsky (1927-2016). Minsky konnte 1969 gemeinsam mit Seymour Papert (1928-2016) zeigen, dass ein einlagiges Perzeptron noch nicht einmal den XOR-Operator auflösen kann, eine elementare Operation des logischen Schließens. Rosenblatt starb bereits 1971 bei einem Bootsunfall und konnte nicht mehr darauf reagieren (bereits ein zweilagiges Perzeptron enthält die Lösung; Spitzer, 128.) So blieb der Ansatz der neuronalen Netze bis zu den Arbeiten von Kohonen und anderen in den 1980ern liegen. »Die in diesem Zusammenhang zum Teil äußerst polemisch geführte Diskussion war letztlich ein Richtungsstreit zwischen den Vertretern der symbolischen Künstlichen Intelligenz und der 'Konnektionisten' um Forschungsgelder.« (Wikipedia) (Papert kam aus Südafrika, war engagiert in der Anti-Apartheid-Bewegung, engster Mitarbeiter von Piaget und seit 1963 Mitarbeiter von Minsky, trat für Reformen des klassischen Frontalunterrichts in den Schulen ein).

– 1960 Least-Mean-Squares-Algorithmus (Algorithmus der kleinsten mittleren Quadrate) von Bernard Widrow (* 1929) und Marcian Edward Hoff (* 1937). Der Algorithmus beruht auf der Methode des steilsten Abstiegs und ist bis heute die mathematische Grundlage der Backpropagation (Fehlerrückführung) und mit ihr des Deep Learning: »Anstelle eines rein an der Korrelation von Aktivierungen orientierten Lernens tritt dann eine sukzessive Korrektur von Ausgabefehlern durch Gewichtsänderungen.« (Spies, 317) Die Resultate eines mehrstufigen, dynamischen Prozesses werden mit den erwarteten Ergebnissen verglichen. Kommt es zu Abweichungen, wird zur Vereinfachung der mathematischen Rechnungen das Quadrat der Abweichung gebildet (daher der Name der Methode), und rückwärtsgehend werden Stufe für Stufe die Gewichte der jeweiligen Zwischenschichten verändert, um das Ergebnis zu optimieren. Bei Änderungen wird geprüft, in welcher Richtung die Änderungen der Gewichte die größten Auswirkungen auf die Fehlerbereinigung haben. Das ist mathematisch die Ableitung (die Steigung) der Veränderung. »Gerät diese Korrektur näherungsweise an einen festen Punkt, an dem sich die Gewichte durch Training nicht weiter verändern, so haben wir eine Nullstelle der Ableitung der Fehlerquadratsumme erreicht.« (Spies, 320) (Der Wikipedia-Eintrag zu Backpropagation fasst in einem Abschnitt gut zusammen, warum Backpropagation wohl nicht in der Biologie vorkommt und insofern keine Intelligenz der Natur ist, sondern eine vom Menschen eingeführte und zum Verständnis natürlicher Vorgänge eingesetzte Methode. Letztlich ist jedoch bis heute unsicher, ob die Natur doch über vergleichbare Methoden verfügt.)

– 1982 Selbstorganisierende Karten nach Teuvo Kohonen (* 1934), das bis heute wichtigste Beispiel für Unüberwachtes Lernen. Bei selbstorganisierenden Karten ordnen sich im Innern eines Nervensystems bestimmte Neuronen wie ein Abbild der empfangenen Reize an. So konnte gezeigt werden, wie sich in einem bestimmten Bereich des menschlichen Gehirns Neuronen entsprechend der topographischen Gestalt des menschlichen Organismus anordnen und eine Karte des Körpers bilden. – Davon ausgehend hat Kohonen 1988 wichtige Beiträge zum Assoziativspeicher geliefert. Spies nennt weitere bedeutende Arbeiten aus dieser Zeit: 1982 die auf Rückkopplung (Feedback) beruhenden Hopfield-Netze (nach John Hopfield, [* 1933]) und 1986 eine Verallgemeinerung der Regel von Widrow und Hoff durch Rumelhart, Hinton und Williams für das Backpropagation. – Aufgrund unzureichender Rechnerleistungen und fehlender Massendaten für das Training des Überwachten Lernens hat jedoch die weitere Entwicklung wiederum stagniert.

– 2005 ist ein Durchbruch der Internet-Anwendungen zu erkennen, gemessen beispielsweise an der Anzahl von Google-Abfragen (nach internetlivestats). Mit der Nutzung des Internet, dem Einsatz von Handys und Smartphones (2007 das erste iPhone von Apple) und Sozialen Diensten wie Facebook (2004 gegründet) sind die Trainingsdaten für überwachtes Lernen explosionsartig gestiegen. Seither liegt eine nahezu unbegrenzte Fülle an Fotos und Audio- und Videodateien vor, mit denen Programme zur Gesichts- und Spracherkennung trainiert werden können. Hinzu kommt in der Industrie die Einführung von Sensorik, die das Herzstück der seit 2011 verkündeten Industrie 4.0 ist. Mit ihr wird nochmals ein unbegrenzter Strom an Trainingsdaten erzeugt. Um das bewältigen zu können, sind ausreichende technische Möglichkeiten notwendig. Programme der natürlichen neuronalen Netze nutzen vor allem Matrix-Verarbeitung. Für ihre Parallelverarbeitung haben sich Grafikkarten als entscheidend erwiesen. Hier ging das 1993 gegründete kalifornische Unternehmen Nvidia voran. Das zusammen genommen erklärt den Aufstieg der Künstlichen Neuronalen Netze, die seit dem spektakulären Erfolg von AlphaGo spätestens 2016 die Möglichkeiten des Deep Learning allgemein bewusst gemacht haben.

Erregbarkeit träumender Nerven und des Immunsystems

Die Erregbarkeit der Zellen aus der Umgebung bzw. von anderen Zellen darf nicht auf eine starre, photographische Abbildung beschränkt sein. Sie muss offen auf Unvorhergesehenes reagieren können, ohne dabei in Beliebigkeit und Willkür zu verfallen. Das ist eine Aufgabenstellung, die der üblichen, an Geometrie und Mechanik orientierten Naturwissenschaft unvertraut ist. Es wird sich als die größte Schwierigkeit erweisen, hierfür überhaupt eine geeignete Sprache zu finden. Daher arbeiten auf diesem Gebiet naturwissenschaftliche Disziplinen wie Physik, Biologie und Mathematik mit Disziplinen aus den Geisteswissenschaften wie Psychologie, Ethnologie und Anthropologie zusammen, und jede von ihnen muss lernen, aus ihren gewohnten Denkmustern auszubrechen. Die Mathematik war als erste mit einer solchen Situation konfrontiert, als sie die imaginären Zahlen einführte. Im Folgenden wird fortlaufend eine ähnliche Erfahrung gemacht werden, wenn von Zellen gesprochen wird, die vor sich hin träumen (imaginieren) und nur aus diesem Zustand heraus aufnahmefähig und kreativ sind und nicht einfach geistesabwesend und zerstreut bleiben. Wer kennt nicht die Erfahrung, wie anregend die auf den ersten Blick störenden Hintergrundgeräusche in einem Café oder einer Bahnfahrt bei der Lösung komplexer Aufgaben sein können?

Die Sinnesorgane sind die Datenschnittstelle für die neuronalen Netze. Wie kann sichergestellt werden, dass keine wichtigen Daten übersehen und zugleich eine Zerstörung oder Beeinträchtigung der Sinnesorgane durch Überflutung oder Überreizung vermieden werden?

(+) Zellen ermöglichen einen geregelten Austausch mit ihrer Umwelt. Nach außen ist die Zelle durch eine Biomembran gleichermaßen geschützt wie geöffnet: Die Biomenbran regelt das dosierte Ein- bzw. Ausströmen von innen wie von außen. Sie ist von einer labyrinthischen Vielzahl von Kanälen durchlöchert, die sich wechselweise öffnen und schließen, wobei es sowohl zu Wechselwirkungen zwischen Innen und Außen wie auch zwischen benachbarten Zellen kommt, die bis heute nur ansatzweise verstanden werden. Dadurch befindet sich die Zelle zunächst in Ruhe (Aufnahmebereitschaft), doch kann das Potentialgefälle (Membranpotential) zwischen Innen und Außen schon bei geringfügiger Erregung von außen überschritten werden und umkippen. Wenn von außen Reize empfangen werden, können sie von unterschiedlichen Rezeptoren (Mechano-, Chemo-, Photo- und Thermorezeptoren) erkannt werden. Doch leitet der Rezeptor nicht den empfangenen Reiz (z.B. ein Photon, ein Geruchsmolekül oder einen mechanischen Stoß) direkt weiter, sondern er wandelt ihn um (Transduktion): Er öffnet oder schließt in der Nähe des Sensors liegende Ionenkanäle, wodurch Ionen ein- bzw. ausströmen und das Potentialgefälle von Innen und Außen geändert wird (Rezeptorpotential). Daher können im Weiteren alle Arten von Reizen einheitlich verarbeitet werden.

»Erregbarkeit beruht auf einem Potentialunterschied zwischen Innen- und Außenseite der Zellmembran (Polarisation), der durch den spezifischen Sinnesreiz depolarisiert und über das Axon fortgeleitet wird. Bei Sinneszellen kommen noch spezielle in die Membran eingebaute Eiweiße hinzu, welche mit dem Membranpotential gekoppelt sind und so auf unterschiedliche physikalische Reize antworten können.« (Walter Rella, E-Mail vom 14.6.2019)

Mit Polarisierung ist in diesem Zusammenhang nicht die Polarisation von Wellen in Transversal- und Longitudinal-Wellen gemeint, sondern die Verstärkung des Gefälles von Innen und Außen, so wie im politischen Bereich von einer Polarisierung gesprochen wird, wenn sich gegensätzliche Extreme verschärfen und die gesellschaftliche Spannung erhöhen. Umgekehrt bedeutet Depolarisierung den Abbau des Gefälles.

(+) In der ausgeglichenen Phase ist die Potentialdifferenz stabil, jedoch nicht völlig unbewegt. Die Systeme befinden sich in einer Art »träumenden Zustand«. Für das Gehirn wurde 2001 die Ruheaktivität nachgewiesen, die mit dem Tagträumen verbunden ist (Default Mode Network, Ruhezustandsnetzwerk). Der träumende Zustand eröffnet mit seiner herabgeminderten Aktivität einen imaginären Raum unendlich vieler Möglichkeiten, in den hinein sich der Traum bewegen und den Ursprungszustand verlassen kann. Diese Möglichkeiten sind meist nur angedeutet, und sie verschwinden oft ebenso schnell wie sie erscheinen. Ich träume von etwas, das sich wieder entzieht, bevor es recht bewusst geworden ist. Der imaginäre Raum kann unterschiedlich angeregt werden, und jede Anregung hat eine eigene Qualität. Mathematisch lassen sich die unterschiedlichen Anregungen beschreiben wie ein Grundton (das ist der träumende oder schlummernde Ruhezustand) und die verschiedenen Obertöne, die sich auf ihm aufbauen.

Die Wahrnehmungsphysiologie kann mit dem Immunsystem verglichen werden: In beiden Fällen ist das System sowohl aufnahmebereit für bereits bekannte Ereignisse, an die es sich erinnern und entsprechend reagieren kann, wie auch auf bisher unbekannte Vorgänge. »Das Immunsystem träumt und phantasiert unbewusst vor sich hin bis es durch etwas geweckt wird, das seinem Traum entspricht.« (Walter Rella, E-Mail vom 14.6.2019) Es befindet sich in einem labilen Zustand innerer Wandlungsfähigkeit. Es ist bereit, auf äußere Reize zu reagieren, auch wenn es sich um bisher unbekannte Eindrücke oder Gefährdungen handelt, indem es einen der zunächst nur im Bereich des Möglichen liegenden Zustände aktiviert und ausbildet. Die Gesamtheit aller möglichen Zustände ist vor-bewusst. Die einzelnen Zustände werden nur bewusst im Moment ihrer Erregung und der dadurch angeregten Verwirklichung.

Der Ausdruck »Traum« oder »träumt vor sich hin« kann unwissenschaftlich klingen und scheint vom Menschen in das Naturgeschehen hineingelegt zu sein. Und doch lassen sich die in den Sinnesorganen zu beobachtenden Vorgänge nicht besser beschreiben: Auch der ausgeglichene Ruhezustand befindet sich nie in absoluter Ruhe. Die außer- und innerzellulären Flüssigkeiten bestehen aus einer solch großen Anzahl beteiligter Moleküle und enthalten immer ein geringes Maß an von anderen Zellen ausgesendeten Botenstoffen wie auch sonstigen Verunreinigungen, weswegen es nie eine perfekte Ordnung wie in einem Kristall gibt. Die unterschiedlichen Ladungsverteilungen der beteiligten Moleküle wirken immer aufeinander und rufen ständig eine kaum zu beobachtende und nicht vorherzusagende innere Bewegung (eine systemische Grundbewegtheit) hervor, so wie jeder bei einer scheinbar ruhigen Wasseroberfläche immer kleinste Veränderungen beobachten kann. Die Kanäle nach außen sind nie ganz geschlossen, wodurch es fortlaufend zu Wechselwirkungen mit der Umgebung und den benachbarten Zellen kommt. Das lässt sich sehr gut vergleichen mit dem Zustand des Tagträumens, wenn das Bewusstsein auf etwas aufmerksam ist und gleichzeitig im Hintergrund von anderen Eindrücken, Gedanken und Gefühlen irritiert und abgelenkt ist. Das erzeugt eine Spannung von Fokussierung und Abwesenheit, aus der heraus es blitzartig zu unerwarteten Kurzschlüssen beider Ebenen kommen kann. Die Tagträume schweben um das bewusste Beobachten herum, nehmen es auf unbewussten Kanälen auf, variieren es und können darüber zu unerwarteten Erkenntnissen führen, wenn sie in das Bewusstsein zurück zu finden vermögen. Dies Wechselspiel von Konzentration und Verträumtheit wird häufig als Mangel empfunden und von vielen Wissenschaftlern als Zerstreutheit, magisches Denken oder Mystizismus abgelehnt, aber nach meinem Eindruck kann nur aus dieser Spannung Kreativität entstehen und etwas Neues emergieren. – Von Foerster entwickelte daraus das 'order from noise' principle: Ihm schwebt die Vorstellung vor, dass es im Grundrauschen Fluktuationen gibt, die in Ordnung umgewandelt werden können. Wenn das gelingt, wird aus etwas zuvor Unbekanntem ein Wissen erzeugt, das anschließend besonders gut erinnert wird. Er nennt als Beispiel: Wenn er in einer Vorlesung den Hörern etwas wirklich Wichtiges vermitteln will, baut er bewusst einen Fehler ein. Die Hörer entdecken ihn und machen ihn darauf aufmerksam, und werden sich diesen Vorgang aus einem Fehler (noise) heraus weit besser merken als wenn alles perfekt vorgetragen worden wäre. (Von Foerster On Self-Organizing Systems and Their Environments, in: von Foerster, 1-19) Ähnlich ist es in der Zellphysiologie: Sie unterscheidet signals und noise: Mit signals sind Informationen gemeint, die bereits bekannt sind und auf die ein vorbereitetes (möglicherweise angeborenes) Reaktionsverhalten bereit steht, mit noise ist dagegen das Unbekannte gemeint, auf das die Zelle zu reagieren lernen muss. Hier ist ihre Kreativität verlangt, aus dem ihr verfügbaren Möglichkeitsfeld das Treffende zu finden.

Im Moment der Sinneswahrnehmung kommen innerhalb jeder Zelle zwei Bewegungen zusammen: Der von außen auftreffende Impuls und die innere Bewegtheit der Flüssigkeit innerhalb der Zelle. Daher ist das Ergebnis nie vollständig vorherzusagen: Es kann sein, dass sich beide Bewegungen ausgleichen oder aufschaukeln. Das führt dazu, dass auf das gleiche äußere Ereignis möglicherweise unterschiedliche Reaktionen erfolgen. Wenn es den nachfolgenden Schichten gelingt, den Erfolg der jeweils ausgelösten Handlungsweisen zu bewerten und per Rückkopplung zurück zu melden, kann das System aus der Vielfalt der unterschiedlichen Reaktionen lernen und auf Dauer die günstigste favorisieren. Entscheidend ist, dass am Anfang aufgrund der Grundbewegtheit der Flüssigkeit keine starre Reaktion erfolgt, sondern ein Möglichkeitsraum verschiedener Alternativen vorliegt. Daher ist es ein zutreffendes Bild zu sagen, dass die Zelle in ihrer Grundbewegtheit »träumt«. Die traditionelle Naturwissenschaft kannte in ihrem Determinismus nur einen eindeutigen Weg. Die Quantenphysik war bereits mit den Quantenfluktuationen auf ein vergleichbares Phänomen gestoßen, doch wurde es noch nicht konsequent als Möglichkeitsfeld eines träumenden Zustands, sondern als unbegreiflicher Welle-Teilchen-Dualismus oder Unbestimmtheitsrelation beschrieben. Sie sah noch nicht die Möglichkeit, dass ein System durch die zufällig gegebenen Variationen daraus lernen kann. Näher kam die Evolutionstheorie, wenn sie von zufälligen Mutationen und der Selektion aus ihnen sprach. Die zufälligen Mutationen entsprechen dem zufälligen Zustand der Grundbewegtheit, auf den ein äußeres Ereignis trifft, und die Selektion dem Lernerfolg. Daher kann ein selbstlernendes System als evolutionäres System bezeichnet werden, das sich in höheren Stufen selbst zu organisieren vermag. (Scheier versteht das Möglichkeitsfeld als Differenzfeld und begründet auf ihm die Logik der medialen Moderne, die die von Frege eingeführte Logik der industriellen Moderne ablöst. Er wählt als Symbol für das Differenzfeld das Zeichen ▒, den Schatten, das in meiner Deutung die Grundbewegtheit des Systems darstellt. Er sieht die Idee einer medialen Logik bei Luhmann angelegt und spricht daher von Luhmanns Schatten.)

Wer sich näher damit zu beschäftigen beginnt, ist überrascht und geradezu überwältigt von der unglaublichen Fülle an Prozessen, die sich wechselweise ausgleichen oder verstärken. Es kommt nicht nur zum Öffnen und Schließen von Ionen-Kanälen, sondern in einer Zelle können Botenstoffe (Neutransmitter) freigesetzt werden, die an die benachbarten Zellen übertragen werden und dort wiederum innere Prozesse auslösen können. – In den Neuronen (Nervenzellen) wird nicht einfach ein elektrischer Puls wie in einem Stromkabel von einem Ende an das andere Ende übertragen und weiter gegeben, sondern der Impuls setzt sich fort, indem entlang des Axons wellenförmig Ionenkanäle geschlossen und geöffnet werden. Das Öffnen und Schließen wird durch komplexe Prozesse ausgelöst, die ihrerseits mit den im Körper verteilten Botenstoffen wechselwirken. Die Vielfalt all dieser Prozesse ist die materielle Erklärung, wie es möglich ist, dass eine im Gehirn entstandene Stimmung wie Müdigkeit, Langeweile, Verliebtsein oder Zeitbewusstsein bis in die tiefsten Ebenen der Wahrnehmung und Reaktionsfähigkeit eingreifen und in einer Rückkoppelung von ihnen ihrerseits beeinflusst werden kann, wenn beispielsweise alles aufzuleuchten scheint (rosa Wolke) oder umgekehrt getrübt und depressiv wirkt.

Es war eine bahnbrechende Leistung, als Freud innerhalb des Träumens die Regeln der Traumlogik erkannte und die traditionelle Vorstellung eines bloß willkürlichen oder an schematischen Symbolen gebundenen Träumens verließ. Auf analoge Weise lassen sich die Regeln der neuronalen Netze verstehen. Dank dieser Regeln sind neuronale Netze in der Lage, auf ihre Weise zu träumen. Wenn das überlieferte traditionelle Denken der Naturwissenschaft an seine Grenzen stößt, vermag die Kunst neue Wege zu finden und entwirft ihrerseits ein Möglichkeitsfeld, das die Technik mit dessen festen Regeln umgibt. Künstlerinnen wie Agnieszka Kurant (* 1978) suchen nach geeigneten Darstellungsformen, um das visualisieren zu können. Mit ihnen bildet sich eine eigene Bewegung einer Empathic AI – Art shapes Industry (Empathische Künstliche Intelligenz - Kunst formt Industrie), so der Titel eines Digitalen Symposiums der Initiative Kultur- und Kreativwirtschaft der Bundesregierung Deutschland am 2.7.2020.

Das hat bei den beteiligten Wissenschaften seit den 1960ern zu einem Paradigmenwechsel geführt, für den stellvertretend Bateson und v. Foerster genannt werden sollen. Gregory Bateson (1904-1980) sprach vom »Unterschied, der einen Unterschied ausmacht«. Damit sind die Unterschiede gemeint, die ursprünglich als Wechsel im Potentialgefälle von Innen und Außen entstehen, im Weiteren als Aktionspotentiale oder über chemische Botenstoffe im Nervensystem weitergeleitet und schließlich vom Gehirn verarbeitet werden (siehe dazu den Beitrag Kybernetik nach Bateson). Heinz v. Foerster (1911-2002) betont den selbstreflexiven Charakter der neuronalen Netze. Für sie steuert nicht mehr ein Geist (Subjekt, Ich) von oben alle Schichten eines Lebewesens, sondern umgekehrt entsteht von der untersten Ebene eine Vielfalt von Prozessen, die schließlich vom Geist in Worte gefasst werden kann. Es ist nicht erst der Geist, der über eine Vielfalt von Handlungsalternativen verfügt und sich frei für eine entscheiden kann, sondern von der untersten Ebene her ist das Möglichkeitsfeld zu betrachten, aus dem sich erst über viele Stufen hinweg die Aktionen des Geistes ergeben. Autonomie und Vielfalt sind für alle Ebenen gegeben: Bereits die untersten Schichten verfügen über eine eigene Autonomie, aus der jeweiligen Mannigfaltigkeit der Eindrücke diejenigen herauszufiltern, die transformiert und als Signale weiter gesendet werden. Kommt es zu Rückkopplungen, dann können die höheren Ebenen die vorgelagerten Ebene beeinflussen, ohne jemals deren Autonomie vollständig zu zerstören.

(+) Jede Ebene verfügt für sich über die Eigenschaft, einen imaginären Raum aufbauen und daraus zurückkehren zu können. Die reelle Achse beschreibt die Informationen, die im neuronalen Netz weiter gegeben werden, die imaginäre Achse das jeweilige Möglichkeitsfeld, ob und wie die Weitergabe erfolgt. Die Dynamik komplexer Räume, die aus imaginären und reellen Zahlen besteht, wird als Analytizität bezeichnet. Mathematisch bedeutet die Analytizität, das bei der Multiplikation zweier komplexer Zahlen nicht nur linear größere Zahlen erreicht werden (so wie z.B. das Produkt zweier natürlichen Zahlen n und m, die größer als 1 sind, mit ›n · m‹ eine neue natürliche Zahl ergibt, die größer als n und m ist), sondern auch eine Drehung erfolgt. Erst mit der Drehung wird die reelle Achse verlassen und der imaginäre Raum erreicht, und dank der Drehung gelingt die Rückkehr aus dem imaginären Raum zur reellen Achse (siehe ausführlicher den Beitrag über die imaginären Zahlen).

Walter Rella sieht im Präfix ‘ana’ eine innere Verbindung zwischen den beiden Begriffen Analytizität und Analogie.

Wenn mit der Analytizität die chemische Sphäre definiert wird, ist mit »chemisch« nicht eine Beschränkung auf die Chemie gemeint, sondern eine Eigenschaft, die sich auf alle Systeme bezieht, die in dieser Weise innerlich bewegt sind. Mit Hegel ist »chemisch« in einem übergreifenden Sinn als eigene Sphäre zwischen »mechanisch« und »organisch« zu verstehen (siehe den Beitrag Das reale Maß – die Logik der chemischen Sphäre). Bei Hegel entspricht der Unterscheidung in innere Bewegtheit und äußere Bewegung, in die reelle und die imaginäre Achse die Unterscheidung in Wahlverwandtschaften innerhalb eines Systems und die Knotenlinie von einem Systemzustand in einen anderen. Mit Wahlverwandtschaften ist in der Chemie gemeint, wenn wahlverwandte Stoffe miteinander chemisch reagieren. Die Knotenlinie der einander wechselnden Systemzustände ergibt sich durch aus der Umgebung hinzugeführter Veränderungen wie z.B. eine Temperaturerhöhung. Die Zellen lassen sich als Beispiele für die chemische Sphäre verstehen. Die Logik der neuronalen Netze ergibt sich aus ihnen.

»Mit einem Beispiel aus der Biologie wäre also der DNS Faden mathematisch hyperkomplex zu handhaben. Die Translation entspricht der Bedeutungserteilung und deren Ergebnis ist ein reelles Protein mit einer bestimmten Funktion, die auch umkehrbar ist und der Booleschen Algebra folgt. Ich denke, dass man das auch auf Chemie und Chemismus übertragen kann (und nicht, wie du suggerierst [S. 41: »Die Analytizität ist die spezifische innere Eigenschaft der chemischen Sphäre«], nur dort gilt). Vielleicht ist ja das, was Spencer-Brown unter Re-entry versteht nichts anderes als das was ich unter Analogie verstehe: Ausgehend vom Imaginären (dem Transfiniten) über das Komplexe ein - dem Anà folgender - Wiedereintritt in den reellen Bereich, der auf höherer Ebene dieselbe Gesetzmäßigkeit wiederholt.« (Walter Rella, E-Mail vom 25.9.2019)

(+) Zusammenfassend: Die Erregbarkeit des Nervensystems stellt sicher, dass der Organismus nicht nur darauf vorbereitet ist, bereits bekannte und / oder genetisch vorbereitete Ereignisse zu erleben, sondern auch bisher unbekannte. Wir erleben derzeit mit der Corona-Pandemie, wie der Körper mit einem Virus fertig werden muss, auf den er nicht vorbereitet war.

Übertragung von Reizen (Bahnen, Filz, Knäuel)

Nicht nur die Sinnesorgane müssen bereit und fähig sein, unterschiedlichste und auch bisher unbekannte Reize aufnehmen zu können, ohne von ihnen überwältigt und überschwemmt zu werden, sondern auch die Übertragungswege von den Sinnesorganen zur Weiterverarbeitung müssen so vielfältig wie möglich gestaltet sein, um sowohl eine Vorverarbeitung zu ermöglichen als auch in einer Rückkopplung nachträgliche Korrekturen vornehmen zu können und dabei nicht die Stabilität des Systems zu verlieren. Die Neurophysiologie und die Molekularbiologie untersuchen empirisch, welche Arten von Wegen und Nachrichtenübertragungen im Körper nachgewiesen werden können. Im Vergleich zu der von ihnen vorgefundenen Vielfalt befinden sich die mathematischen und logischen Methoden nach wie vor erst in den Anfängen, Logik nicht nur traditionell entlang von Urteils- und Schluss-Ketten und damit zweiwertig zu entwerfen, sondern den komplexen Strukturen neuronaler Netze gerecht zu werden. Wie es aussieht, ist das neuronale Netz darauf eingestellt und vorbereitet, neue Wege zu gehen, wenn die bekannten Wege versagen. Mir ist nicht bekannt, ob und wie weit das neurophysiologisch untersucht wurde. Die Betrachtung neuronaler Netze konzentriert sich bisher zunächst mit guten Gründen auf besonders einfache Fälle, das sind linear fortschreitende Vorgänge, bei denen es immerhin bei Backpropagation stufenweise Rücksprünge gibt. Im Folgenden soll eine Übersicht gegeben werden, welche weiteren Möglichkeiten denkbar sind und von neurophysiologischen und molekularbiologischen Forschungen ausgehen können.

Parallele Bahnen und Kreisläufe, Additivität und Gedächtnis

(+) McCulloch hat untersucht, wie Signale übertragen werden. Er formuliert zwei Axiome:

Additivität. Es gibt nie nur eine einzige Übertragungslinie (Kommunikationskanal), sondern es sind immer mehrere Kanäle parallel geschaltet. Das erzeugt bewusst eine Redundanz. Mit der Additivität wird ein Schwellwert gesetzt: Erst wenn eine bestimmte Anzahl von Impulsen das gleiche meldet, wird das ernst genommen. Nach der Hebbschen Regel werden nicht nur nahe beieinander liegende parallele Wege addiert, sondern verstärkt. Das ergibt einen nicht-linearen, dynamischen Prozess.

Gedächtnis. Ein Impuls kreist. Das kann zwei Auswirkungen haben: Das Gedächtnis kann zu den einzelnen Impulsen addiert werden und ihnen mehr Gewicht verleihen. Was gerade geschieht, kommt zwar nur vor, aber es hat in der Vergangenheit bereits ähnliche Fälle gegeben und ist also ernst zu nehmen. Negativ-Abgleich: Das Gedächtnis erwartet etwas. Wenn dies fehlt, meldet es eine Störung.

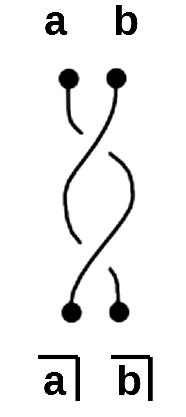

(+) Sind die von Spencer-Brown eingeführten Netzwerke eine Weiterführung? Auch Spencer-Brown spricht von Zählen (Additivität) und Gedächtnis (memory). Sowohl dem Zählen wie dem Gedächtnis liegt als gemeinsame Eigenschaft die Oszillation zugrunde: Beim Zählen wird fortlaufend der gleiche Schritt von n zu ›n + 1‹ wiederholt. Das kann mit etwas Phantasie als Oszillieren zwischen n und ›n + 1‹ bezeichnet werden. Beim Gedächtnis oszilliert ein bestimmter Eindruck und kehrt regelmäßig wieder.

Verfilzung

Wer sich die Zeichnungen von Ramón y Cajal anschaut, wird sehen, wie im neuronalen Netz die verschiedenen Bahnen nicht so gleichmäßig und rechteckig angeordnet sind, wie wir es von Schaltplänen elektronischer Geräte bis hin zu komplexen Computer-Chips gewohnt sind, sondern eine eigentümliche räumliche Gestalt annehmen. Arthur Collings stellte bei der Spencer-Brown-Konferenz 2019 in Liverpool Netzwerke vor mit nicht nur einem Input, sondern zwei voneinander unabhängigen Inputs, die zu zwei voneinander unabhängigen Outputs führen. Im einfachsten Fall laufen zwei parallele Wege von jeweils einem Input zu einem Output, doch kann es auch zu Verfilzungen (Flechten, Zöpfen, braids) kommen, die zu einer eigenen Flechtfrisur von Rastazöpfen führen, und ihrer mathematischen Struktur, den braid groups.

In einem sehr einfachen Beispiel gibt es zwei Inputs mit den Argumenten a und b, die als Output zu ⃧a und ⃧b führen. Sie können sich miteinander verflechten.

Der Phantasie sind keine Grenzen gesetzt, welche weiteren – aus der Quantenmechanik bekannten – Möglichkeiten denkbar sind: So können zwei Wege einander durch Resonanz beeinflussen. Oder es sind virtuelle Sprünge in die Vergangenheit und Zukunft denkbar, wenn ein Weg durch ein Ereignis beeinflusst wird, das auf dem anderen Weg in der Vergangenheit bzw. in der Zukunft liegt. Die moderne Literatur kennt unbegrenzt viele Beispiele, wie sich Vorgänge dieser Art erzählen lassen.

(+) Sind im Filz oder der Verfilzung eigene Eigenschaften enthalten? Liegt im Filz etwas verborgen, wodurch sich die Selbstorganisation unterscheidet?

»Dass aus einer Zygote ein Neugeborenes werden kann, setzt eine unzählbare Menge von parallel, seriell und verfilzt angeordneter Schaltkreise voraus, die von der DNS orchestriert werden und die sämtlich Analytizität aufweisen müssen.« (Walter Rella, E-Mail vom 22.8.2019)

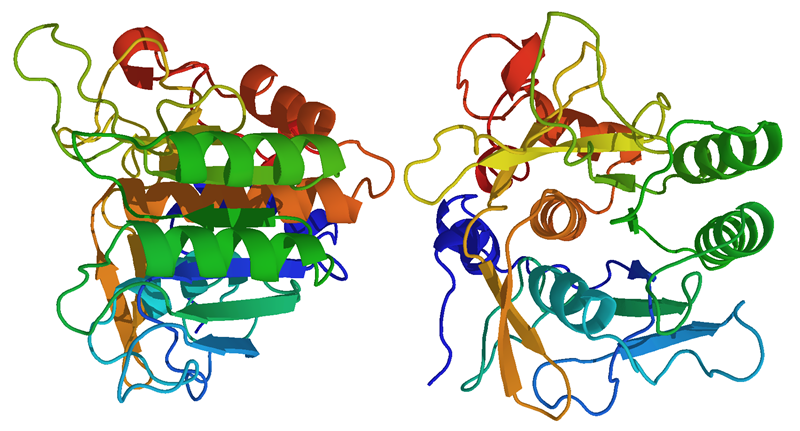

Dreidimensionale Knäuel

(+) Auf den ersten Blick sehen die DNS-Fäden wie verdrillte, eindimensionale Bänder einer Turingmaschine aus. Dank verbesserter Mikroskopie können sie inzwischen weit genauer analysiert werden. So ist zu sehen, welche eigenartigen Knäuel sie bilden.

Subtilisin Carlsberg, Alcalase®

Quelle: Wikipedia mit Verweis auf Proteindatabank rcsb.org

Urheber: Von own work - adapted from http://www.pdb.org/pdb/files/1fa4.pdb using PyMOL, Gemeinfrei, Link

(+) Sprache der DNS. Es genügt nicht, die DNS als Sprache mit eindimensional angeordneten Buchstaben anzusehen, die fortlaufend in Zeilen, Seiten und Büchern aufgeschrieben sind. Eine Sprache enthält mehr als eine Kette von Buchstaben. Sie enthält die imaginäre Kraft, Vorstellungen bilden zu können und aus ihnen zurückzukehren.

»Der variable DNS Faden ist das Substrat für den Informationsgehalt eines Organismus.« (Walter Rella, E-Mail vom 21.10.2019) Der übliche Evolutionsbiologe »spricht von 'Buchstaben' der DNS, von 'Worten' und 'Syntax' und vergleicht sie mit einer Sprache, ohne zu bedenken, dass auch die Buchstabenkombinatorik letztlich hyperkomplexes - im Imaginären beheimatetes - Substrat von Kommunikation ist.« (Walter Rella, E-Mail vom 21.10.2019)

Die Variation entspricht dem Freiheitsgrad des Imaginären und muss sich ins Reale drehen.

Unsicheres Wissen (Überwachtes und unüberwachtes Lernen)

Künstliches Lernen durch neuronale Netze verläuft viel banaler als vielleicht von Künstlicher Intelligenz erwartet wird. Das neuronale Netz arbeitet nicht wie ein Ingenieur, der eine Aufgabe analysiert, die Problemstellung zu verstehen versucht bis er sich ausreichend sachkundig fühlt, um einen auf klaren Regeln beruhenden Plan entwerfen und umsetzen zu können. Bei den heute eingesetzten neuronalen Netzen handelt es sich überwiegend um Überwachtes Lernen. Das Wissen kommt von außen, und das neuronale Netz lernt, es auf andere bisher unbekannte Fälle des gleichen Aufgabengebiets übertragen zu können.

Das Standardbeispiel für Künstliche Neuronale Netze: Wie kann ein neuronales Netz ein von Hand geschriebenes t von einem l, i oder einer 1 unterscheiden? Es hat keinerlei Vorwissen über Buchstaben, Graphologie oder Sprache, sondern zerlegt ein Foto des handgeschriebenen Buchstabens in ein Raster von beispielsweise ›24 · 24 = 576‹ Quadrate. Für jedes Quadrat wird dessen durchschnittlicher Dunkelheits- und Farbwert gemessen. Aus diesen Messungen wird schrittweise ein Vorschlag errechnet, um welchen Buchstaben es sich handelt. In der Trainingsphase wird von einem Trainer von außen geprüft, ob das Ergebnis zutrifft. Im Fehlerfall wird das Programm fortlaufend angepasst und verbessert.

Das ist ungefähr so, als ob in der Schule ein Lehrer den Schülern Bilder von etwas zeigt, das sie noch nicht kennen und unterscheiden können, und sie dennoch auffordert, spontan mit einem Wort zu beschreiben, was sie dort sehen. Der Lehrer wird sich das anhören und den Schülern sagen, wie gut sie bereits das richtige Ergebnis getroffen haben. Mit jedem neuen Versuch werden sie schrittweise besser werden. Was hierbei in ihrem Gehirn geschieht, weiß keiner. Es ist nur bekannt, dass die Schüler erst etwas sehen, und dann dafür nach geführtem Lernen die richtige Bezeichnung nennen. Und es ist bekannt, dass es im Gehirn eine Vielzahl miteinander vernetzter Neuronen gibt, die vom Sehnerv den visuellen Eindruck empfangen, verarbeiten und schließlich die Muskeln des Mundes steuern, das richtige Wort auszusprechen.

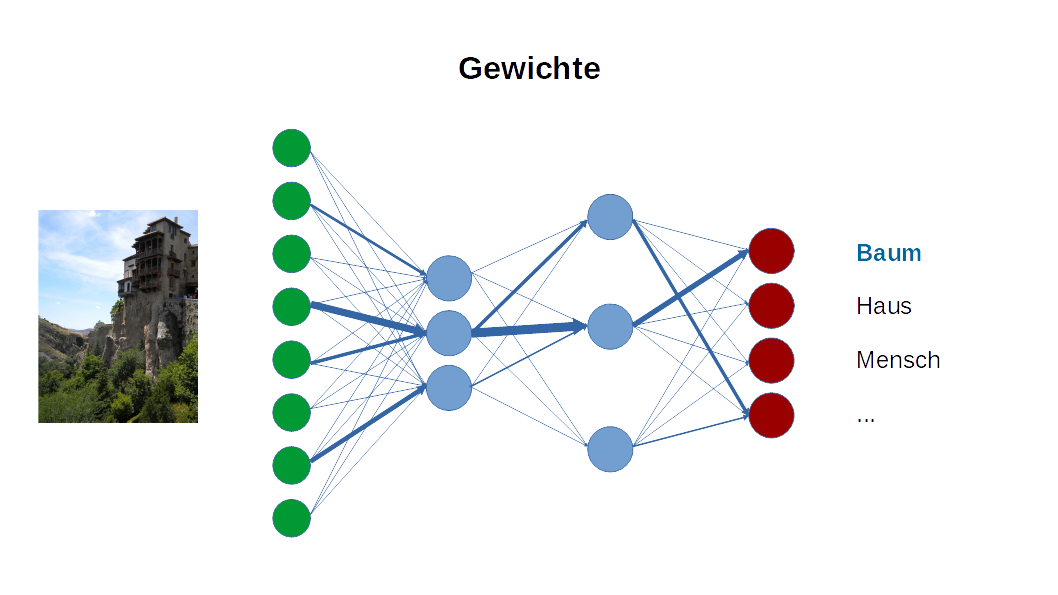

Das kann in einem einfachen Diagramm dargestellt werden:

„Hängende Häuser” in der spanischen Provinz Cuenca

Urheber des Fotos: Daytonarolexboston - Eigenes Werk, CC BY-SA 3.0, Link

Die Ausgänge der Sehnerven sind grün dargestellt, und in rot liegt eine vorbereitete Liste vor, aus der das neuronale Netz einen Vorschlag auswählen soll. Entscheidend ist, was an den blau gezeichneten Neuronen der Verarbeitungsstufen geschieht. Die Verarbeitung erfolgt teils seriell von einer Schicht zur nächsten und teils parallel innerhalb jeder Schicht. Die Intelligenz liegt darin, mit welchen Gewichten die einzelnen Verbindungen zwischen den Neuronen versehen werden. Im ersten Ansatz sind alle Verbindungen gleich gewichtet. Unterschiedliche Gewichte können durch verstärke Linien der Verbindungen hervorgehoben werden:

Zum Beispiel werden in der Regel die Punkte am Rande des Blickfelds weniger stark beachtet als in der Mitte. Erregt ein Ereignis am Rande des Gesehenen die Aufmerksamkeit, wird jeder den Kopf wenden und die Augen entsprechend ausrichten, um es besser sehen zu können.

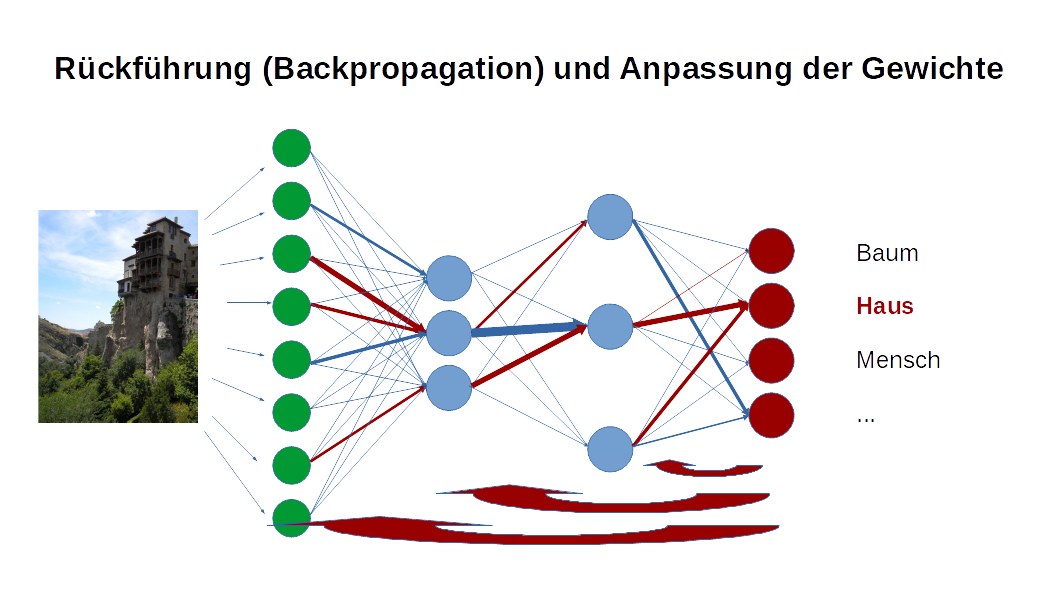

Das Training besteht darin, dass zurückgemeldet wird, ob das erzeugte Resultat zutrifft oder nicht. Wenn in diesem Beispiel gesagt wird, dass ein Baum gesehen wurde, während es sich um ein auf den ersten Blick nicht erkennbares, ungewöhnlich gebautes Haus handelt, können die Gewichte angepasst werden, so dass aus dem gleichen Seheindruck das Wort ‘Haus’ abgeleitet wird. Die Korrektur erfolgt schrittweise rückwärts entlang der Verarbeitungsschichten. Die veränderten Gewichte sind dunkelrot hervorgehoben:

Das ist die Grundidee der Neuronalen Netze. Mit etwas Mathematik lassen sich die Korrekturen optimieren. Wer an Details interessiert ist, kann den sehr anschaulich geschriebenen Beitrag von Nadja Kurz zum Thema Handschrifterkennung mittels neuronaler Netze mit Backpropagation von der Hochschule RheinMain lesen; PDF.

Verblüffenderweise gibt es bei den Lernphasen eines neuronalen Netzes Übereinstimmungen mit den von Jean Piaget (1896-1980) in den 1960ern vorgestellten Entwicklungsphasen von Kindern. Darauf haben in den 1980ern die Psychologen und Kognitionswissenschaftler David Rumelhart (* 1941) und James Lloyd McClelland (* 1948) hingewiesen (Spitzer, 213). Sie untersuchten als Beispiel, wie ein Kind und ein neuronales Netz die physikalischen Gesetze einer Balkenwaage lernt:

(i) Kinder bis 5 Jahren glauben, dass sich immer das schwerere Gewicht senkt.

(ii) In Phase 2 wird die Bedeutung der Entfernung des Gewichts vom Drehpunkt erkannt, aber nur bei gleich groß Gewichten.

(iii) Gewicht und Entfernung werden verstanden, aber noch nicht konsistent berücksichtigt.

(iv) Produkt von Gewicht und Abstand wird verstanden.

»McClelland konnte zeigen, dass die empirisch bei Kindern ermittelten Phasen auch bei einer Computersimulation auftraten. [...] Der wesentliche Punkt dieser Simulationsexperimente besteht darin, dass während der gesamten Simulation Synapsengewichte kontinuierlich den Erfahrungen des Netzwerks angepasst wurden.« (Spitzer, 214)

Zusammenfassend ist jedoch wichtig festzuhalten: Es wurde kein Verständnis einer Sache erworben, sondern das neuronale Netz hat gelernt, von außen vorgegebene Anforderungen zu erfüllen. Und es sind keine Regeln aufgestellt worden, nach denen die Neugewichtung der Verbindungen zwischen den Neuronen erfolgt, sondern diese sind in einem Verfahren von Versuch und Irrtum empirisch vorgenommen worden.

Unsicheres Wissen: Dennoch sind die Ergebnisse verblüffend. Ist das neuronale Netz anfangs ausgesprochen »dumm«, lernt es nach einer Weile Fotos, Audio- und Videosequenzen immer besser zu deuten, bis es der menschlichen Wahrnehmung überlegen ist. Die Fortschritte zeigen sich besonders in der Gesichtserkennung, aber bereits bei der Buchstabenerkennung ist zu verstehen, worum es geht: Wir wissen, dass der Buchstabe t aus einem etwas längeren senkrechten Strich, einem kürzeren waagerechten Strich in der Mitte und möglicherweise einer nach rechts gerichteten Rundung am Fuß besteht. In vielen Fällen ist der senkrechte Strich nach rechts geneigt, in manchen Fällen aber auch nach links. Es kann auch sein, dass es keine Schleife am Fuß oder eine nach links gerichtete Schleife gibt. Diese Varianten beschreiben die Situation unsicheren Wissens. Neuronale Netze müssen fehlertolerant sein und sind nach einer langen und rechnerintensiven Phase des Trainings meist besser als der Mensch befähigt, aus unsicherem Wissen klare Ergebnisse zu gewinnen.

Kategorien und ihre Plastizität: Die Wahrnehmungsphysiologie ist im Verlaufe der Evolution entstanden. Es gibt unterschiedliche Kategorien für Sehen, Hören, Tasten, Schmecken und Riechen mit eigenen Wahrnehmungsorganen, Verarbeitungsschichten und zuständigen Bereichen im Gehirn. Es ist eine der großartigsten Eigenschaften des Gehirns, dass die Verarbeitungsschichten sich gegenseitig unterstützen können, falls eine von ihnen beschädigt ist (Plastizität). Die wechselweise Verbindung unterschiedlicher Wahrnehmungsarten ist weitgehend ungeklärt. Beim assoziativen Erinnern wird z.B. beim Bild eines Kuchens die Situation erinnert, wann dieses Stück Kuchen zum ersten Mal gegessen wurde (die Beleuchtung des Raums, die anderen beteiligten Personen etc., siehe hierzu die berühmte Erzählung von Marcel Proust am Beginn seines Romans Auf der Suche nach der verlorenen Zeit). Menschen mit kinästhetischen Fähigkeiten können Töne sehen und Farben hören. Die Fähigkeit kinästhetischer Wahrnehmung ist wiederum korreliert mit der Fähigkeit, sich im Traum des Träumens bewusst zu sein. Demgegenüber sind die bis heute bekannten neuronalen Netze weniger entwickelt. Was ein neuronales Netz für das Sehen gelernt hat, lässt sich nicht auf das Hören übertragen. Das gilt erst recht für andere Anwendung. Ein neuronales Netz, das hervorragend Go spielen kann, versagt beim Sehen. Die Fähigkeit des Gehirns, sich aus unterschiedlichen Eindrücken ein einheitliches Bild der aktuellen Situation zu machen, kann bis heute durch kein neuronales Netz nachgebildet werden.

Kleine Perzeptionen: Auf dem Weg von der sinnlichen Wahrnehmung bis zur Bildung von Vorstellungen und Worten gehen viele Informationen verloren. Sie sind dennoch unbewusst im Gehirn abgelegt. Leibniz unterschied zwischen den bewussten Erfahrungen, die in einer bewussten Vorstellung münden, und der Vielzahl der kleinen Perzeptionen, die zwar wahrgenommen und irgendwo im Gedächtnis gespeichert werden, aber zu keinen Vorstellungen führen.

Implizites Wissen: Bei den meisten neuronalen Netzen wird im Training nicht nur gesagt, ob ein Resultat richtig oder falsch war, sondern wie nahe es dem gewünschten Ergebnis gekommen ist. An dieser Stelle ist das Vorwissen des Trainers entscheidend, denn nur er kann die Qualität des Ergebnisses beurteilen. Er muss die unterschiedlichen, möglichen Ergebnisse danach bewerten und ordnen, wie gut sie übereinstimmen. In manchen Fällen ist das rein geometrisch und damit maschinell möglich: So kann z.B. gemessen werden, um wie viel ähnlicher der Buchstabe l dem Buchstaben t im Vergleich zum Buchstaben q ist. Wird dagegen z.B. ein neuronales Netz trainiert, das die schier unendliche und für den Menschen mit bloßem Auge kaum unterscheidbare Vielfalt an Arten von Gräsern erkennen kann, ist wesentlich mehr Vorwissen notwendig.

Beispiele: Einfache, anschauliche Beispiele sind bei Jann Raveling Was ist ein neuronales Netz? (wfb Bremen) und Chris Nicholson A Beginner's Guide to Neural Networks and Deep Learning (pathmind) zu finden. Oliver Zeigermann hat bei der Cebit 2017 in einem Beitrag #heiseshowXXL ausgeführt: Heute gibt es eine unglaublich gewachsene Rechner-Power, insbesondere bei Firmen wie Google, Amazon etc., und es gibt geradezu eine Revolution bei den Trainingsdaten. Jeder, der in Google oder anderen ähnlichen Programmen arbeitet, trainiert das Programm: Das Programm sieht die Eingabe und kann anhand der Auswahl der Vorschläge durch den Anwender per Backpropagation seine Gewichte anpassen. Beispiele: Google API wertet vorgelegte Gesichter auf Emotionen etc. aus. DeepL nutzt ein neuronales Netz für das Übersetzen in Fremdsprachen und lernt fortlaufend aus den Eingabemöglichkeiten seiner Anwender, die am Bildschirm die vorgeschlagene Übersetzung korrigieren können.

Induktives Schließen: Der kritische Punkt der neuronale Netze liegt an der Stelle, wenn aus den Trainingsfällen auf neue, noch nicht trainierte Beispiele geschlossen wird. Aus Sicht der Logik handelt es sich um induktives Schließen von einer endlichen und damit notwendig begrenzten Anzahl an Beispielen auf eine im Prinzip unbegrenzte Anzahl unbekannter Fälle. Das induktive Schließen wird seit den Anfängen der Logik bei Aristoteles skeptisch gesehen. Wie kann vermieden werden, dass mit den neuen, noch nicht trainierten Fällen Fehler auftreten? Wenn neuronale Netze z.B. bei der Diagnose von Krankheiten oder der Steuerung selbstfahrender Autos eingesetzt werden, stellt sich die ethische Frage nach der Verantwortung, falls es zu Fehlern mit möglicherweise tödlichem Ausgang kommt. – Ein harmloses Beispiel nach Raveling: Ein künstliches Netz wurde trainiert, Äpfel und Birnen zu unterscheiden. Wird ihm das Bild eines Feuerwehrautos vorgelegt, hält es dies für einen Apfel, weil die Farbe Rot nur für Äpfel und nicht für Birnen gilt.

Kritik: Geht mit den Algorithmen das Grundverständnis verloren, was das Unsichere (und damit zugleich Offene) unsicheren Wissens ist, und anhand welcher Kriterien erkannt werden kann, wie nahe das Ergebnis dem gewünschten Resultat kommt? Werden mit den Algorithmen die uns nach wie vor weitgehend unbekannten Methoden kreativen und intuitiven Denkens und der Phantasie verstellt und verschmutzt? Man stelle sich zum Beispiel vor, ein neuronales Netz würde anhand vorgelegter Geräusche lernen, in welchen Geräuschen Musik nachweisbar ist. Droht das das Verständnis von Musik auf ein Mittelmaß zu reduzieren und gibt neuartigen, avantgardistischen Ideen keine Chance? Oder würde möglicherweise umgekehrt als Musik erkannt, was bisher nur als Geräusch erscheint? Es dürfte sich lohnen mit zu verfolgen, welchen Erfolg neuronale Netze haben, die beispielsweise Musik im Stil von Bach oder Beethoven komponieren (Algorithmische Komposition und als Beispiele DeepBach und AIVA). Es sind Doppelblindversuche denkbar, bei denen Hörer entscheiden, welches Stück von Bach oder Beethoven und welches von einem neuronalen Netz stammt.

Neues Paradigma der Wissenschaft?

Entsteht mit den neuronalen Netzen ein neues Paradigma der Wissenschaft? Zeigt sich hier die Logik der medialen Moderne? Möglicherweise ist unser meist in eindimensionalen Ursachenketten denkendes, kausales Verständnis zu einseitig. Können die Methoden und Verfahren der neuronalen Netze helfen, in anderen Wissenschaften Fragen zu lösen, die im Rahmen des zweiwertigen, kausalen Denkens in Paradoxien und Zirkelschlüsse führen?

Quantenmechanik: Bis heute ist es eine offene Frage, welche Wege die Teilchen im Doppel-Spalt-Experiment gehen, bevor sie auf dem dahinter stehenden Schirm ein statistisch sehr genau vorherzusagendes Wellenmuster bilden. David Bohm hat eine mathematische Methode entworfen, um widerspruchsfrei die Wege berechnen zu können, aber es ist experimentell nicht nachweisbar, ob sie diese Wege wirklich gehen. Ist es stattdessen möglich, die Perspektive völlig zu ändern und das Doppel-Spalt-Experiment aus verborgenen Schichten eines Deep Learning zu verstehen? Die Eingabe wäre der Teilchenstrahler, die Ausgabe das Auftreffen der Teilchen auf dem Schirm. Es wird nicht mehr gefragt, welche Wege die Teilchen gehen und warum diese nicht nachgewiesen werden können, sondern es wird angenommen, dass das Teilchensystem dank verborgener Verarbeitungsschichten gelernt hat, die ausgestrahlten Teilchen wellenförmig auf einem Schirm zu verteilen. Schon an diesem Beispiel zeigt sich, wie ungewohnt der Ansatz der neuronalen Netze ist und welches Umdenken er verlangt.

Sprache: Ist eine Verallgemeinerung der Gesichts- und Schrifterkennung auf Sprache möglich: Eingabeschicht sind die sinnlichen Reize, Ausgabeschicht die Worte der Sprache. Ist mit diesem Ansatz eine Übertragung des Verständnisses der Sprachfähigkeit der Menschen auf die jeweils spezifische Sprache anderer Lebewesen wie der Bienen oder der Wale und möglicherweise sogar in größeren Horizonten auf die Sprache der Steine oder die Sprache der Blumen möglich? Das führt weiter zur Semiotik der Biomoleküle. Möglicherweise liegt auch ihnen und ihren Basiselementen, deren Anordnung und räumlicher Konfiguration ein Lernvorgang zu Grunde.

Gaia 5.0: Geologie und Meteorologie beschreiben langfristige Änderungen in der Entwicklung des Planeten Erde, von der Plattentektonik bis zu Wirbelstürmen und Strömungen im Wasser. Wie viele charakteristische Dimensionen gibt es? Es kann eine 5-Dimensionalität vermutet werden. Ist mit ihnen eine Lernfähigkeit verbunden, die das komplexe System der Erde und ihrer Sphären zu stabilisieren vermag? (Quehenberger u.a.)

Emergenz: Lässt sich die Emergenz als neuronales Netz verstehen, wenn sich eine vorliegende Schicht über mehrere Verarbeitungsschichten in eine höhere Schicht wandelt (emergiert)? Die bisher genannten Beispiele wie die Sprache wären dann Beispiele von Emergenz.

Evolution: Kann der gleiche Vorgang als Evolution verstanden werden? Schon jetzt gibt es Zweifel, die Evolution ausschließlich aus zufällig entstandenen Mutationen zu erklären, von denen sich erst im nachhinein diejenige mit den besten Überlebenschancen durchsetzt (Selektion). Handelt es sich bei der Evolution um ein neuronales Netz, mit dem die Entwicklung in eine höhere Stufe gelingt? Ist es möglich, für Emergenz und Evolution ein einheitliches Modell zu entwickeln, oder zumindest innere Verwandtschaften zwischen beiden aufzuzeigen?

Eigenwerte nach v. Foerster und Spencer-Brown: Bisher wird nur untersucht, wie sich mit Backpropagation rückwirkend die Gewichte verbessern lassen. Der Prozess des Backpropagation endet, wenn ein lokales Minimum erreicht ist. Können darüber hinaus im Prozess der fortlaufenden Veränderungen Eigenwerte nachgewiesen werden, bzw. zeigen sich – um eine andere Ausdrucksweise zu gebrauchen – Fixpunkte?

Möglichkeitsraum, imaginäre Zahlen: Mit der Variabilität der Gewichte der Verarbeitungsschichten entsteht ein Möglichkeitsraum, in dem sich beschreiben lässt, welche Durchgänge durch die Schichten möglich sind. Gibt es übergreifende Strukturen in diesem Möglichkeitsraum, mit dem sich die Prozesse der neuronalen Netze und insbesondere die Backpropagation unterstützen und besser verstehen lassen? Das könnte in der Konsequenz dazu führen, dass mit einem tieferen Verständnis stärker auf die selbstorganisierenden Verfahren (selbstorganisierende Karten) gebaut werden kann und das überwachte Lernen an Bedeutung verliert.

Data Mining: Methoden des Data Mining, an riesigen Datenmengen innere Strukturen zu erkennen. Eingabeschicht sind die unübersehbaren Datenmengen, Ausgabeschicht die dort erkannten Strukturen.

Empirismus: Zur Zeit führt der Einsatz neuronaler Netze zu einer neuen Art von Empirismus. Es wird ausschließlich auf empirische Daten vertraut, die induktiv zu Verbesserungen der Gewichtungen innerhalb der Verarbeitungsschichten genutzt werden. Ich kann mir vorstellen, dass dies nur ein Zwischenschritt ist, der in einer ersten Phase ermöglicht, die Beschränkungen der heute auf dem eindimensionalen Kausalitätsdenken beruhenden Wissenschaft zu überwinden und in späteren Phasen zu einem neuen, höheren Verständnis der Wirklichkeit führt. Aber das ist aus heutiger Sicht nur eine Intuition und bleibt eine Spekulation, für deren Wahrscheinlichkeit es noch keine Anzeichen gibt. Dennoch ist die Philosophie gefragt, aus ihrer eigenen Perspektive offene Punkte zu erkennen und in Zusammenarbeit mit der empirischen Forschung eine übergreifende Orientierung zu finden, die über bloßen Empirismus hinausgeht.

Literatur

Kate Crawford und Ryan Calo: Künstliche Intelligenz, wo bleibt der Mensch?

in Spektrum der Wissenschaft vom 2.1.2017; Link

Winfried D'Avis: Denkende Maschinen, in telepolis vom 27. 9. 2020

Heinrich von Foerster: Understanding understanding, New York u.a. 2003

Alexander Graf: Multitalent für Sprache, GPT-3; spektrum der wissenschaft vom 11.8.2020

Phillip Guddemi: Toward Batesonian sociocybernetics: From Naven to the mind beyond the skin

in: Kybernetes 36(7/8):905-914 · August 2007; PDF in Researchgate

Alexander Heimerl, Elisabeth André: Transparente Künstliche Intelligenz für jedermann? 19.05.2020; Link

Nadja Kurz: Handschrifterkennung mittels neuronaler Netze mit Backpropagation, Hochschule RheinMain Wiesbaden im Wintersemester 2015-16; PDF

Konrad Lehmann: Warum erzeugt das Gehirn neue Neuronen?

in: Telepolis vom 2.6.2015; Link

Warren McCulloch: Verkörperungen des Geistes, Wien, New York 2000 [1965]

Chris Nicholson: A Beginner's Guide to Neural Networks and Deep Learning; pathmind

John Pavlus: Versteht der Computer uns jetzt wirklich?; spektrum vom 15.2.2020

Renate Quehenberger, Sergio Rubin, Leyla Kern, Daniel Tirelli: GAIA 5.0 - A five-dimensional geometry for the 3D visualization of Earth´ climate complexity, Wien 2020

Diego L. Rapoport, Jean Claude Pérez: Golden ratio and Klein bottle Logophysics: the Keys of the Codes of Life and Cognition

in: Quantum Biosystems, November 2018, Vol 9, Issue 2, Page 8-76

Jann Raveling: Was ist ein neuronales Netz? wfb Bremen vom 29.1.2019 mit Links zu YouTube-Beiträgen

Annika Röcker: Interaktom - Das soziale Netzwerk unserer Proteine; spektrum vom 8.4.2020

Gerhard Roth: Wie einzigartig ist der Mensch?, Heidelberg 2010

Claus-Artur Scheier: Luhmanns Schatten – Zur Funktion der Philosophie in der medialen Moderne, Hamburg 2016

Marcus Spies: Unsicheres Wissen, Heidelberg, Berlin, Oxford 1993

Manfred Spitzer: Geist im Netz, Heidelberg, Berlin 2000

Natalie Wolchover: Erfülle uns nur einen einzigen Wunsch! (Entgleitende KI-Algorithmen); spektrum vom 19.4.2020

Bildnachweis: Gemeinfrei, Link