Walter TydecksSpencer-Brown Gesetze der Form– Einführung und weiterführende Ideen |

|

Beitrag für das Philosophische Colloquium der Akademie 55plus Darmstadt am 13. und 27. März 2017 (wesentlich erweiterte Fassung, Version 12.7.2019)

Inhaltsverzeichnis

Einleitung

Motive

»Distinction is Perfect Continence«

Proto-Arithmetik und Proto-Algebra

Re-entry

(Prozesse |

Zeit |

Schaltkreise)

Beobachter

Anhang

Einleitung

George Spencer-Brown (1923-2016) kommt aus England und stammt aus der gleichen Grafschaft Lincolnshire wie Newton. Er hat schon früh parallel und übergreifend an Fragen der Mathematik, Ingenieurstechnik und Psychologie gearbeitet, so im 2. Weltkrieg als Funker, Nachrichtentechniker und Hypno-Schmerztherapeut bei der Royal Navy, 1950-51 am Trinity College Cambridge bei Ludwig Wittgenstein (1889-1951), ab 1960 mit dem Mathematiker und Philosophen Bertrand Russell (1872-1970), auf dem Gebiet der Psychotherapie und Kindererziehung mit Ronald D. Laing (1927-1987), bei dem er an einer Therapie teilnahm und ihn umgekehrt in Mathematik unterrichtete, und daneben war er Schriftsteller, Liedermacher, Schachspieler, Spieleerfinder, Segelflieger (mit zwei Weltrekorden), also eine durchaus ungewöhnliche Persönlichkeit. 1959-61 Chief Logic Designer bei Mullard Equipment, 1963-64 Advisor bei British Rail, 1963-1968 Projekte an Mathematischen Instituten in England, 1968-69 Vollzeitbeschäftigung als Psychotherapeut mit Hypnose-Techniken, später nur noch in Teilzeit. Ab 1976 befristete Professorentätigkeiten an Universitäten in Australien und USA. 1977-78 Beratung für Xerox. In späteren Jahren verarmte er und zog sich zurück, konnte jedoch auf dem Grundstück des Marquess of Bath leben, einem früheren Schüler von ihm. – Gesetze der Form erschien 1969 dank Förderung durch Bertrand Russell. Durch eine positive Rezension von Heinz von Foerster (1911-2002) gewann es eine gewisse Aufmerksamkeit, ist aber dennoch in der Mathematik, Informatik und Philosophie bis heute im Grunde ein Randphänomen geblieben, das kaum jemandem bekannt ist. In Deutschland hat vor allem der Soziologe Niklas Luhmann (1927-1998) die Ideen von Spencer-Brown aufgegriffen und sah in ihnen einen neuen Zugang zur Systemtheorie, der aus seiner Sicht eine Befreiung von der traditionellen Philosophie ermöglicht. Eine erste Einführung in die Logik gibt es bei Wikipedia. Louis Kauffman (* 1945), Uni Chicago, hat den Ansatz weiter ausgebaut. Es gibt Bezüge zur Informatik (von Foerster), Kybernetik (Wiener), Antipsychiatrie (Laing), Anthropologie (Bateson), Psychologie (Piaget) und Kommunikationswissenschaft (Watzlawick), Systemwissenschaft (Luhmann, Baecker), selbstreferenzielle Systeme (Maturana, Varela). – Im persönlichen Umgang soll Spencer-Brown eher schwierig gewesen sein, was wohl damit zusammenhängt, dass er – wie ich meine zurecht – seine Arbeiten auf einem Rang mit denen von Aristoteles und Frege gesehen hat und über die fehlende Anerkennung enttäuscht war.

Entsprechend gibt es nur wenig Sekundärliteratur. Die Texte von Spencer-Brown sind außerordentlich dicht geschrieben. Die Gesetze der Form umfassen im Haupttext 77 Seiten, die mit einigen Vorworten und Eigenkommentaren ergänzt wurden. 1973 fand am Esalen-Institut an der kalifornischen Pazifikkünste eine Tagung statt, an der Spencer-Brown, Bateson, von Foerster u.a. teilnahmen (American University of Masters Conference, abgekürzt AUM-Konferenz). Damit sind die Quellentexte bereits aufgezählt. Von Dirk Baecker erhielt ich ein 1992 von Spencer-Brown geschriebenes, unveröffentlichtes Typoscript An Introduction to Reductors. In Deutschland gibt es in Nachfolge von Luhmann an der anthroposophisch geprägten Privatuniversität Witten/Herdecke im Ruhrgebiet sowie in Heidelberg und München Kreise, die sich regelmäßig mit Spencer-Brown beschäftigen. Als Sekundärliteratur habe ich daher von Luhman das komplexe Kapitel über Beobachtung aus seinem 1990 erschienenen Werk Wissenschaft der Gesellschaft herangezogen, in dem er seine Position zu Spencer-Brown darstellt, darauf aufbauend einen von seinem Schüler Dirk Baecker 1993 herausgegebenen Sammelband Kalkül der Form, der unter anderem auch die Rezension von Heinz von Foerster enthält, sowie den von Luhmann 1995 in Wien gehaltenen Vortrag Die neuzeitlichen Wissenschaften und die Phänomenologie, in dem er seine philosophische Position gegenüber Husserl und Spencer-Brown ausführt. Claus-Artur Scheier hat 2016 in Luhmanns Schatten dessen Ansatz mit der neueren französischen Philosophie in Verbindung gebracht und auf eine eigene Weise formalisiert. In Heidelberg erschien 2005 eine kurze Einführung in die Logik von Spencer-Brown durch Felix Lau und in München wesentlich ausführlicher 2004 eine 2009 erweiterte Einführung durch Tatjana Schönwälder-Kuntze, Katrin Wille, Thomas Hölscher. Sie kommen aus dem Umfeld von Matthias Varga von Kibéd (* 1950), der wiederum Schüler des Logikers Ulrich Blau (* 1940) ist. Blau hat Standardbücher über neue Richtungen der Logik verfasst, in denen er jedoch auf Spencer-Brown nicht eingeht. Varga von Kibéd hat sich fernöstlichen Traditionen zugewandt und ist vor allem aktiv geworden in der Gründung, Einführung und Vermarktung neuer Methoden der Systemischen Strukturaufstellung, die sich im weitesten Sinn auf Spencer-Brown berufen. Zusammenfassend kann gesagt werden, dass Spencer-Brown vor allem auf die Theorie selbstreferenzieller Systeme und auf neue Methoden der systemischen Therapie Einfluss gewonnen hat, jedoch in der traditionellen Philosophie, Mathematik und Informatik weitgehend ignoriert wird und unbekannt geblieben ist.

Dieser Beitrag ist auch für mich eine erste Annäherung und Einführung und kann nur versuchen, sich weitergehenden philosophischen Fragen zu nähern. Ich vermute jedoch, dass in seinem Ansatz ein Potential enthalten ist, das noch bei weitem nicht erschöpft ist. Einige weiterführende Gedanken finden sich im Beitrag Freiheit des Grundes.

Motive

In seiner äußerst selbstreflektierten Arbeit betont Spencer-Brown, dass es keine Unterscheidung ohne ein bestimmtes Motiv gibt (»There can be no distinction without motive«, LoF, 1). Das scheint mir der beste Zugang zu diesem ungewöhnlichen Werk zu sein. Um seine Gedanken zu verstehen, ist es kaum möglich, sich auf das zu stützen, was bisher in Mathematik, Logik oder Philosophie gelernt und praktiziert wurde. Im Gegenteil regt er dazu an, vieles davon mühsam wieder zu verlernen und sich der tieferen Motive wieder bewusst zu werden, die ursprünglich der Begeisterung für die Mathematik zugrunde lagen und weitgehend verschüttet worden sind.

Lügner-Paradoxon und negative Selbstbezüglichkeit

Das erste Motiv ist sicher die Beschäftigung mit dem Lügner-Paradox ›Dieser Satz ist falsch‹. Mit ihm waren die logischen Grundlagen der Mathematik und damit aller Naturwissenschaft elementar in Frage gestellt. Das löste eine tiefe Verunsicherung aus, die heute – seit wir uns daran »gewöhnt« haben – kaum mehr vorstellbar ist. Denn zur gleichen Zeit waren mit dem Niedergang aller überlieferten religiösen und mythischen Glaubensvorstellungen die Mathematik und die Naturwissenschaft zur einzigen Kraft geworden, die Identität und Sicherheit zu geben versprach. Wenn nun auch ihre Grundlagen erschüttert werden, droht jeder Halt verloren zu gehen. Robert Musil hat das 1902 in Die Verwirrungen des Zöglings Törleß wunderbar gestaltet. Jeder, der zwischen 1900 und 1980 Mathematik studierte, stieß nahezu zwangsläufig auf die Russellschen Antinomien und wurde in eine Krise gestoßen vergleichbar der skeptizistischen Herausforderung an die Philosophie. Erst der lang anhaltende ökonomische Aufschwung in den westlichen Ländern nach 1945 hat zumindest für eine Weile alle Bedenken und Fragen dieser Art in den Hintergrund drängen können und blanken Pragmatismus und gewöhnlichen Materialismus als neue Werte etabliert. Welche Gefahr soll von einer solchen Antinomie ausgehen, wenn doch drum herum die Anwendungen der gleichen Wissenschaft so erfolgreich sind? In solchen Zeiten haben die Fragen eines Spencer-Brown kaum Aussicht auf Resonanz, drohen sie doch die Fragen wieder aufzurühren, die gerade mühsam unter den Teppich gekehrt worden waren.

Das Lügner-Paradoxon ist das berühmteste Beispiel für negative Selbstbezüglichkeit: Der Satz bezieht sich auf sich selbst, und er verneint sich. Das führt zum Paradox: Wenn seine Aussage richtig ist, ist er falsch, und wenn seine Aussage falsch ist, ist er richtig.

Dies Paradox kann in die unterschiedlichsten Formen gebracht werden, was Ulrich Blau bis in die äußersten Verästelungen getrieben hat mit dem Ergebnis, dass es in der gewohnten Logik nichts gibt, was aus diesem Paradox herausführt.

Der Satz ist keineswegs nur eine logische Spielerei, die jeder Jugendliche irgendwann im Alter von 12 bis 16 Jahren durchmacht und damit die IV. Stufe des kognitiven Denkens (das formale Denken) im Sinne von Jean Piaget (1896-1980) erreicht, sondern ist in der ursprünglichen Formulierung »ein Kreter sagt, dass alle Kreter lügen« von mythologischer Bedeutung, als die Kreter mit der Angst fertig werden mussten, dass sie auf der Insel Kreta Gott getötet haben könnten. In der Philosophie hat er bei Hegel systematische Bedeutung erhalten und gilt als das entscheidende Merkmal der dialektischen Methode.

Bertrand Russell war anfangs Hegelianer, konnte sich aber mit den spekulativen Sätzen Hegels über den Widerspruch nicht zufrieden geben. Für ihn musste es auch eine formale Lösung geben, die den Anforderungen der traditionellen Logik standhält. Das ist ihm mit dem Verbot selbstbezüglicher Sätze nur negativ gelungen, und er war daher begeistert, als Spencer-Brown eine völlig neue, formale Lösung präsentieren konnte.

Imaginäre Zahlen

Spencer-Brown suchte einen Ausweg nach dem Vorbild der imaginären Zahlen. Die imaginären Zahlen sind innerhalb der Mathematik ein eigenartiger, geheimnisvoller Fremdkörper. Schon der Name imaginär ist völlig untypisch für das übliche mathematische Denken. Sind diese Zahlen imaginär wie ein bloßer Traum, oder sind sie bloße Bilder, virtuelle Objekte des Denkens, entsprungen aus der Imagination (Einbildungskraft, Phantasie) der Seele? Was zeichnet eine mathematische Imago gegenüber einer psychologischen Imago aus? Fragen dieser Art haben Spencer-Brown nach seiner Therapie bei Laing sicher sehr bewegt.

Der Ausdruck imaginäre Zahl geht auf Descartes und Euler zurück. Für Mathematiker ist es ein in sich widerspruchsfreier Formalismus, den Zahlenraum zu erweitern, und für Ingenieure und Physiker ist es ein überaus hilfreiches Werkzeug, komplexe Gleichungen zu vereinfachen, auch wenn sie in der Regel kaum die Frage beantworten können, warum das mit den imaginären Zahlen möglich ist. Als Nachrichtentechniker war Spencer-Brown zweifellos mit dieser Bedeutung vertraut und hatte gelernt, wie Ingenieure und Naturwissenschaftler einfach mit solchen Zahlen rechnen, weil das gut geht und sich bewährt, ohne nach den mathematischen Grundlagen zu fragen.

Im Vorwort zur ersten amerikanischen Ausgabe von Laws of Form hat er 1972 eine verblüffende Beziehung der imaginären Zahlen zur Frage der Russellschen Antinomie gesehen. Russell und Whitehead wollten die drohende Antinomie in der Typen-Theorie mit dem Verbot selbstbezüglicher Elemente ausschließen. Das hielt Spencer-Brown für einen Fehler. »Mistakenly, as it now turns out.« (LoF, ix) Spencer-Brown berichtet, dass er Russell 1967 getroffen und ihm gezeigt hat, wie er ohne diesen Ausschluss arbeiten kann. »The Theory was, he said, the most arbitrary thing he and Whitehead had ever had to do, not really a theory but a stopgap, and he was glad to have lived long enough to see the matter resolved.« (LoF, x)

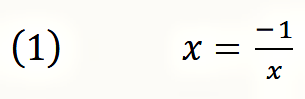

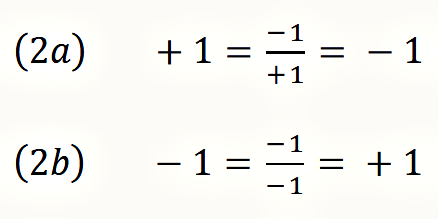

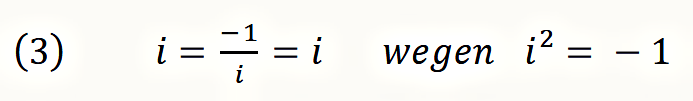

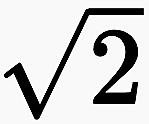

Um innerhalb der Arithmetik eine negative Selbstbezüglichkeit zu definieren, ist eine Gleichung aufzustellen, in der eine Variable x als ihr eigener Kehrwert auftritt und mit dem Minus-Zeichen negiert wird:

Mit dieser Gleichung ist die negative Selbstbezüglichkeit formalisiert: Der Kehrwert steht für den Selbstbezug, das Minuszeichen für die Negation.

Diese Gleichung sieht auf den ersten Blick ebenso harmlos aus wie wenn jemand zum ersten Mal den Satz hört ›dieser Satz ist falsch‹. Jeder hält das im ersten Moment für eine gewöhnliche Aussage über einen anderen Satz (einer sagt, ›der Himmmel ist grün‹ und ein anderer antwortet darauf ›dieser Satz ist falsch‹), bis dessen innere Sprengkraft durchschaut wird, wenn er sich auf sich selbst bezieht. So sieht auch Formel (1) auf den ersten Blick nicht ungewöhnlich aus. Das in ihr enthaltene Paradox wird sichtbar, wenn für x der Wert 1 oder der Wert −1 eingesetzt wird:

1 und −1 sind die einfachst-möglichen Zahlen, und sie zeigen, dass es für diese Formel keine natürliche Zahl als Lösung gibt. Mit ihr hat Spencer-Brown das Paradox der negativen Selbstbezüglichkeit innerhalb der Arithmetik nachgebildet. (In der tradionellen Logik und der analytischen Philosophie geschulte Wissenschaftler bestreiten allerdings, dass es zulässig ist, auf diese Weise das ursprünglich mengentheoretisch formulierte Russellsche Paradoxon zu transformieren und eine verblüffende Lösung zu finden. So habe ich es beim Wittgenstein-Symposium 2018 in Kirchberg am Wechsel erlebt.)

Whitehead und Russell hatten nur den Ausweg gesehen, Fragen dieser Art mit dem unbestimmten, dritten »Wahrheitswert« ‘bedeutungslos‘ (meaningless) zu versehen und auszuschließen. Während mit diesem Wahrheitswert logisch und mathematisch nicht operiert werden kann, kann eine Lösung mit den imaginären Zahlen gefunden werden, die das Rechnen mit einem zusätzlich Wahrheitswert erlaubt. Die imaginären Zahlen stehen wie die y-Achse senkrecht zur Zahlenachse. Ihre Einheit ist die neu eingeführte Zahl i. Sowohl i wie auch −i sind Lösungen von Gleichung (1).

Darum geht es Spencer-Brown. Er fragt sich, ob nach dem Vorbild der imaginären Zahlen in der Arithmetik auch imaginäre Zahlen in der Logik eingeführt werden können mit weitreichenden Folgen für das logische Denken.

»What we do in Chapter 11 is extend the concept of Boolean algebras, which means that a valid argument may contain not just three classes of statement, but four: true, false, meaningless, and imaginary.« (LoF, xi)

Die traditionelle Logik ist zugleich zu einfach und zu komplex

Diese Beispiele zeigen bereits den neuen Zugang zur Logik bei Spencer-Brown. Er war mit der überlieferten Logik völlig unzufrieden. Die ist für ihn banal, um nicht zu sagen kindisch, und zugleich unnötig kompliziert.

(1) Die traditionelle Logik ist einerseits zu einfach, geradezu kindisch.

Wer einmal Lehrbücher der Logik gelesen hat mit ihren Beispielen, versteht was Spencer-Brown meint. Eine typische logische Aufgabe lautet: »Welche der folgenden Behauptungen ist wahr: Einige Äpfel sind Bananen. Alle Äpfel sind Bananen. Einige Bananen sind keine Äpfel. Manche Bananen sind Äpfel.« Die richtige Lösung ist versteckt in dem Satz »Einige Bananen sind keine Äpfel.« Darauf kommt niemand gleich, weil das niemand im alltäglichen Leben so sagen würde, denn jeder würde spontan diesen Satz so verstehen, dass er implizit auch die falsche Aussage enthält, dass es einige Bananen gibt, die Äpfel sind. Aber formal ist dieser Satz richtig, und das soll eine Aufgabe wie diese zeigen. Sie soll ein abstraktes Verständnis für Logik lehren, das unabhängig ist von einem inhaltlichen Vorverständnis und Sprachgefühl.

Ist Logik nichts weiter als die Suche nach witzigen Logeleien, über die jeder schmunzeln muss? Das kann beliebig ausgebaut werden: Ist ein Satz wie »die Zahl 2 ist gelb« wahr oder falsch, und was kann aus diesem Satz gefolgert werden? Was ist von dem Schluss zu halten: »Wenn John keine Kinder hat, ist sowohl die Aussage wahr, ›Alle Kinder von John schlafen‹ wie auch die konträre Aussage ›Keins von Johns Kindern schläft‘.« Ist damit der Satz des Widerspruchs widerlegt? Die analytische Philosophie denkt sich nach diesem Muster bis heute immer neue Beispiele aus und schlägt sich seit Jahrzehnten mit Fragen dieser Art herum, obwohl bereits Herbert Marc#use (1898-1979) diese Art zu denken in den 1960ern verspottet hatte (Der eindimensionale Mensch, 1964) und darin im Grunde eine bestimmte Art der Erziehung zur Dummheit sieht, die leider auch an den Universitäten nahezu alle philosophischen Fakultäten dominiert, an denen Philosophen dieser Richtung bevorzugt eingestellt werden. Offenbar sollen in großem Stil an den Universitäten Menschen und vor allem Lehrer ausgebildet werden, die mit dieser Art von Logik in den Schulen Unterricht erteilen können.

Aufgrund seiner Ausbildung in Logik hatte Spencer-Brown eine Stelle bekommen, um Schaltkreise zu programmieren, und merkte schnell:

»The logic questions in university degree papers were childishly easy compared with the questions I had to answer, and answer rightly, in engineering. We had to devise machinery which not only involved translation into logic sentences with as many as two hundred variables and a thousand logical constants--AND's, OR's, IMPLIES, etc.--not only had to do this, but also had to do them in a way that would be as simple as possible to make them economically possible to construct--and furthermore, since in many cases lives depended upon our getting it right, we had to be sure that we did get it right.« (AUM, Session One)

Im Ergebnis konnten er und die anderen Entwickler sich zwar allgemein auf ihr logisches Denkvermögen verlassen, programmierten aber drauf los und gaben es sehr schnell auf, ihre Programme systematisch gemäß den Regeln der gelernten Logik zu entwerfen und zu überprüfen, sondern waren zufrieden als sie sahen, dass die von ihnen programmierten Schaltkreise funktionieren, ohne das logisch erklären oder beweisen zu können. So geht es nach meiner Erfahrung den meisten Programmierern, und es hinterlässt dennoch ein Unbehagen, dass es eine andere Art von Logik geben müsste, die der Praxis des Programmierens näher kommt und hilfreicher ist. (Wer hat sich als Programmierer nicht mit Methoden wie z.B. dem logisch aufgebauten Programmablaufplan herumgeschlagen und es irgendwann fallen gelassen, weil der Aufwand, Programmerweiterungen in Methoden dieser Art nachzubilden größer ist als die Programmierung und das Austesten. Bei komplexen Programmen sind logische Methoden dieser Art komplizierter als der Programmtext selbst, und in der Realität hat sich für Dokumentationen ein übersichtlicher Pseudocode durchgesetzt, der die Algorithmen in einer einfach zu lesenden Sprache darstellt.)

(2) Zugleich ist die Logik viel zu komplex.

Fast gebetsmühlenartig wird am Anfang jeder Logik- und Mathematik-Vorlesung ein großer Aufwand mit der Einführung unterschiedlichster Zeichen getrieben, obwohl die jeder intuitiv versteht. Das sind eigene Zeichen für Konstanten, Variablen, logische Operationen wie ∧, ∨, ¬ und Quantoren wie ∀ und ∃. Die unterschiedlichen Professoren und Lehrbücher überbieten einander darin, den erforderlichen Begriffsapparat so abstrakt wie möglich einzuführen. Ein Beispiel ist die online verfügbare Vorlesung Endliche Modelltheorie von Geschke:

»1.1. Strukturen. Ein Vokabular  ist eine endliche Menge bestehend aus Relationssymbolen P, Q, R, …, Funktionssymbolen f, g, h, … und Konstantensymbolen c, d, … Jedes Relations- und Funktionssymbol trägt eine natürliche Zahl ≥ 1, seine Stelligkeit.

ist eine endliche Menge bestehend aus Relationssymbolen P, Q, R, …, Funktionssymbolen f, g, h, … und Konstantensymbolen c, d, … Jedes Relations- und Funktionssymbol trägt eine natürliche Zahl ≥ 1, seine Stelligkeit.

Fixiere ein Vokabular  . Eine Struktur

. Eine Struktur  für

für  (eine

(eine  -Struktur) ist eine Menge A zusammen mit

-Struktur) ist eine Menge A zusammen mit

(S1) Relationen

⊆ An für jedes n-stellige Relationssymbol

⊆ An für jedes n-stellige Relationssymbol  ∈

∈  ,

,

(S2) Funktionen

: Am → A für jedes m-stellige Funktionssymbol

: Am → A für jedes m-stellige Funktionssymbol  ∈

∈  und

und

(S3) Konstanten

∈ A für jedes Konstantensymbol

∈ A für jedes Konstantensymbol  ∈

∈  .

.

Oft identifiziert man eine Struktur  mit ihrer unterliegenden Menge A, schreibt also A anstatt

mit ihrer unterliegenden Menge A, schreibt also A anstatt  .« (Geschke, S. 1)

.« (Geschke, S. 1)

Wer Mathematik und Logik studiert hat, versteht, warum auf solche Weise eine Vorlesung eingeleitet wird, und doch hat jeder das Gefühl, dass an dieser Art an die Sache heranzugehen etwas nicht stimmen kann. Am Ende wird versucht, alles deduktiv aus einer einzigen Lehre abzuleiten. Das gelingt nicht. Stattdessen scheint sich heute die Ansicht durchgesetzt zu haben, dass am Anfang mehr oder weniger gleichberechtigt die Mengenlehre, die Modelltheorie und die Theorie formaler Sprachen stehen. Die Mengenlehre kommt nicht aus ohne eine formale Sprache, die formale Sprache nutzt die Mengenlehre, jede Lehre kann als ein Modell verstanden werden, das aber wiederum wie an diesem Beispiel zu sehen einer formalen Sprache und mengentheoretischer Operationen bedarf. Im Ergebnis entsteht der Eindruck, dass es nicht gelungen ist, die unterschiedlichen Lehren auf ihre einfachsten Elemente zurückzuführen, und die große Abstraktheit und der komplexe technische Apparat im Grunde eine Flucht sind, um dieser Frage auszuweichen.

Für Spencer-Brown ist diese ganze Richtung ein Irrweg. Seine erste Grundentscheidung ist daher, eine wesentliche Reduktion vorzunehmen und damit einen Bereich zu eröffnen, der als Proto-Logik oder als Proto-Mathematik bezeichnet werden kann. Er versteht seine Herangehensweise als »perfect continence« (LoF, 1), eine Mäßigkeit und Selbstkontrolle bei Klärung der logischen Grundlagen.

Logik und Zeit

Die klassische Logik gilt unabhängig von der Zeit. Mit ihr werden nur Aussagen getroffen und verknüpft, die für sich zeitlos gültig sind. Eine Tatsache oder eine Beobachtung bleibt immer bestehen, selbst bei Sätzen, die sich auf einen bestimmten Zeitpunkt beziehen. Ein Satz wie ›Am 24.2.2017 sind in Bensheim die ersten Krokusse des Jahres 2017 aufgeblüht‹ gilt auch dann noch, wenn die Krokusse längst wieder verblüht sind. Er gilt selbst dann, wenn er sich als eine Täuschung erweist, denn dieser Satz ist für sich genommen eine Gegebenheit meines Denkens. So hatte Wittgenstein 1921 den Tractatus logico-philosophicus begründet: »1 Die Welt ist alles, was der Fall ist. [...] 1.13 Die Tatsachen im logischen Raum sind die Welt.« Für ihn ist die Welt die Gesamtheit aller Protokollsätze. Spencer-Brown hatte 1950-51 miterlebt, wie Wittgenstein über diesen Ansatz hinausgehen wollte. Es ist zu wenig, die Logik auf Sätzen dieser Art und ihren Verknüpfungen zu begründen.

Nun ist die Logik dabei nicht stehen geblieben. So wurde 1954 von Paul Lorenzen (1915-1994) die operative Modallogik entwickelt, mit der die Unterschiede von Möglichkeit, Wirklichkeit und Notwendigkeit logisch erfasst und formalisiert werden sollen. Der technische Apparat ist so weit wie möglich angepasst an die traditionelle Logik. Diese Richtung hat in Verbindung mit der Quantenlogik einen gewissen Aufschwung genommen. – Auch in der Modallogik fehlt noch die Berücksichtigung der Zeit. Das wurde zur gleichen Zeit in den 1950ern mit einer Temporalen Logik zu lösen versucht. Wer sich die bisher vorliegenden Ergebnisse sowohl der Modallogik wie der temporalen Logik ansieht, wird verstehen, warum das nicht das ist, was Spencer-Brown suchte. Er ging auf einem ganz anderen Weg von der praktischen Erfahrung aus, dass beim Programmieren das Gleichheitszeichen kontextabhängig als Zuweisung oder als Übereinstimmung verstanden wird.

Auf diesen Aspekt hat Elena Esposito hingewiesen (Esposito in Baecker Kalkül der Form, 108-110). Bei Computer-Anweisungen ist es weder ein Widerspruch noch ein Paradox, wenn geschrieben wird:

(4a) i = i + 1

(4b) a = f(a)

In der Zuweisung (4a) steht das Zeichen i anders als in mathematischen Gleichungen nicht für eine Variable, für die zwar eine beliebige Zahl eingesetzt werden kann, die dann aber im Verlaufe der Rechnung festzuhalten ist, sondern für einen Speicherplatz, dessen Inhalt im Verlaufe der Programm-Ausführung verändert werden kann. Bei beiden Zuweisungen liegt das Ergebnis auf der linken Seite zeitlich später als die Rechenoperation auf der rechten Seite. Die Zuweisung ›i = i + 1‹ ist eine der am häufigsten verwendeten Programmierzeilen, wenn in einer Schleife im Verlaufe einer zeitlichen Wiederholung mitgezählt wird, wie oft die Schleife durchlaufen wurde. Und ebenso ist die Anweisung ›a = f(a)‹ eine zeitliche Operation, die aus dem Speicherplatz a den dort aktuell gespeicherten Wert einliest, ihn mit einer Funktion f(a) neu berechnet und anschließend das Ergebnis dem Speicherplatz a neu zuweist. Das a auf der linken Seite hat daher in der Regel einen anderen Wert als das a auf der rechten Seite. Wenn z.B. in einer Anlagenbuchhaltung am Speicherplatz a der Wert einer Anlage steht und mit der Funktion f neu berechnet wird, verändert sich dadurch der Inhalt am Speicherplatz a. Auf der rechten Seite steht das »alte a«, auf der linken Seite das mit einer Funktion f berechnete »neue a«. Die Verständnisschwierigkeit entsteht, weil in der Programmierung abgekürzt wird: Das Zeichen a steht sowohl für den Speicherplatz wie für den Wert, der an diesem Speicherplatz gespeichert ist.

Aufzuklären, was hier beim Programmieren geschieht und dafür eine geeignete Logik zu finden, ist für mich eins der stärksten Motive von Spencer-Brown. Wenn seine Arbeiten bisher von der Informatik nahezu vollständig ignoriert werden, zeigt das für mich nur, in welchem Ausmaß die Informatik unfähig ist, gegenüber ihrem eigenen Tun so etwas wie eine transzendentale Wende zu finden, wie es Kant innerhalb der Philosophie geleistet hatte, und wie es nach meinem Eindruck Spencer-Brown für die Programmierung suchte. Gerade für einen Mathematiker und Informatiker ist das Buch von Spencer-Brown nicht einfach zu lesen. Er ist zwar besser vertraut als andere mit formalen Überlegungen dieser Art, muss sich aber von festgefahrenen Vorurteilen befreien. Er muss – wie Spencer-Brown sagte – viel verlernen, und das Verlernen schrittweise angehen, um nicht bereits beim ersten Schritt in zu große Verwirrung zu geraten.

Spencer-Brown antwortete auf eine Frage von John Lilly (1915-2001) (Neurophysiologe, Delfin-Forschung, Untersuchung von Drogen und ihren Wirkungen wie LSD, Einfluss auf New Age):

»LILLY: Have you formulated or recommended an order of unlearning?

SPENCER BROWN: I can't remember having done so. I think that, having considered the question, the order of unlearning is different for each person, because what we unlearn first is what we learned last. I guess that's the order of unlearning. If you dig too deep too soon you will have a catastrophe; because if you unlearn something really important, in the sense of deeply imported in you, without first unlearning the more superficial importation, then you undermine the whole structure of your personality, which will collapse.

Therefore, you proceed by stages, the last learned is the first unlearned, and this way you could proceed safely.« (AUM, first session)

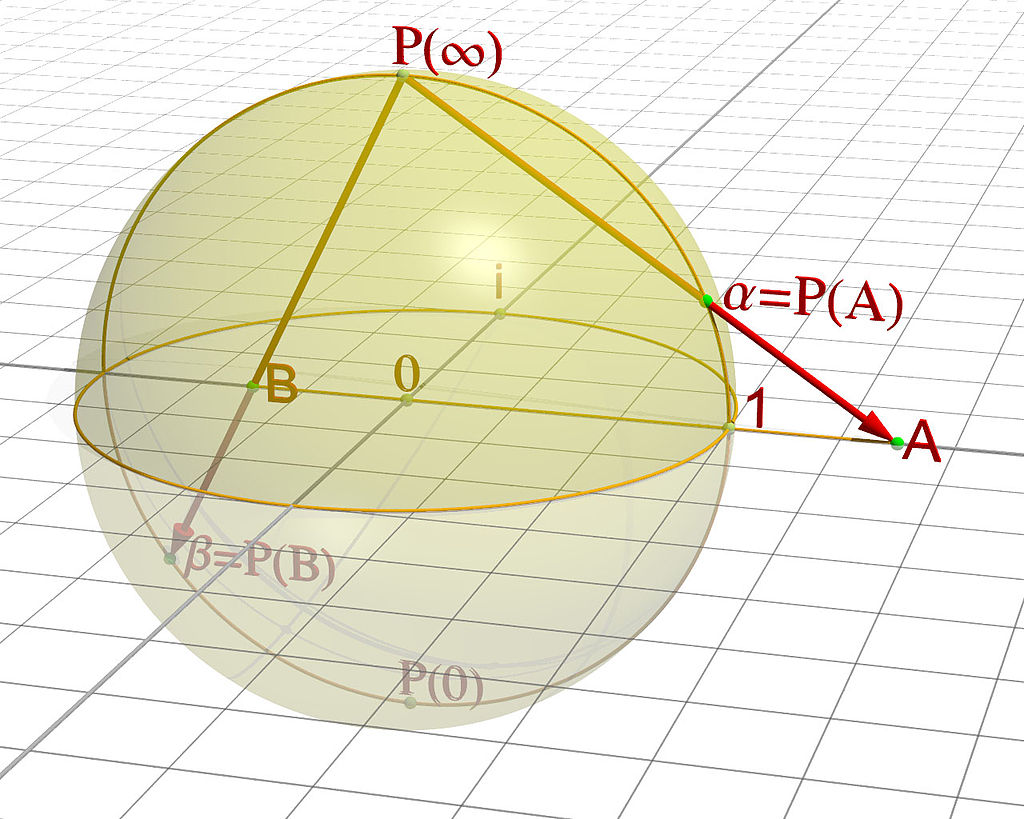

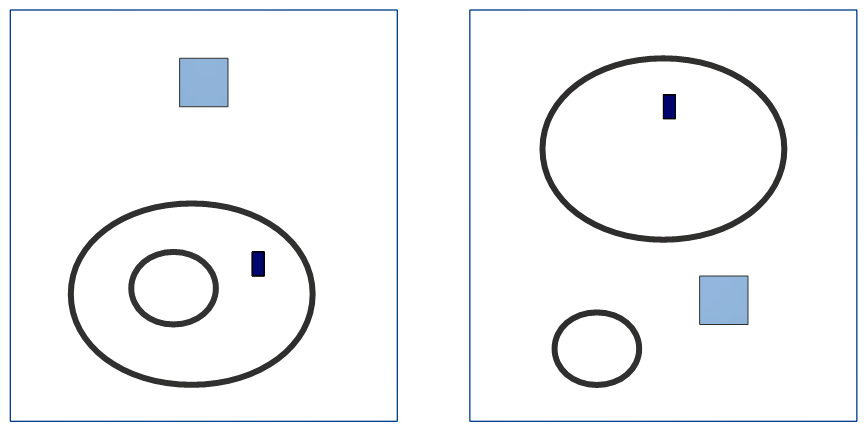

Der Einfluss des Beobachters

Die transzendentale Wende von Kant ist eine neue Art von Selbstbeobachtung, mit der das Denken sein eigenes Tun untersucht. Kant war sich bewusst, dass er mit ihr eine Wende nachvollzog, die sich bereits in der Astronomie mit der kopernikanischen Wende ereignet hatte, als deutlich geworden war, in welcher Weise das Weltbild vom jeweiligen Standort des Beobachters abhängig ist. Die Welt stellt sich anders dar, wenn sie in Gedanken nicht mehr von der Erde aus, sondern von der Sonne aus gesehen wird. Sachlich bleibt alles gleich, aber die Bewegungen der Sonne, Planeten und des Mondes sind mathematisch wesentlich einfacher in Bewegungsgleichungen zu bringen. An ihnen werden Muster erkennbar (die Keplerschen Gesetze), die mit bloßem Augenschein von der Erde aus nicht zu sehen sind.

Bei Einstein spielt die Geschwindigkeit, mit der sich ein Beobachter bewegt, eine Rolle, wie er andere Bewegungen wahrnimmt. In der Quantenmechanik wird befürchtet, dass nichts so gemessen werden kann, wie es ist, da es durch die Messung verändert wird, also der Messvorgang in die Messung eingreift.

Von noch größerer Bedeutung ist der Beobachter für die Psychologie und Soziologie, und nicht ohne Grund ist vor allem dort die Lehre von Spencer-Brown aufgegriffen worden. Kant hielt eine wissenschaftliche Psychologie für unmöglich. Für ihn war schon fraglich, ob die Chemie jemals eine Wissenschaft mit mathematischen Methoden werden kann, aber für die Psychologie hielt er das für ganz ausgeschlossen. Jedes denkende Wesen wird merken, wenn es beobachtet wird, und entsprechend reagieren. Daher kann der Beobachter nie sicher sein, ob der andere nur deshalb so ist, wie er ist, weil er sich auf ihn einstellt. Die Psychoanalyse berücksichtigt das teilweise, seit sie mit Freud das Phänomen der Übertragung kennt, wenn ein Patient sich unbemerkt den Erwartungen des Analytikers anpasst und dieser sich umgekehrt unbewusst so verhält, wie es der Patient von ihm erwartet (Gegenübertragung).

»Aber auch nicht einmal als systematische Zergliederungskunst, oder Experimentallehre, kann sie (die Psychologie, t.) der Chemie jemals nahe kommen, weil sich in ihr das Mannigfaltige der inneren Beobachtung nur durch bloße Gedankenteilung von einander absondern, nicht aber abgesondert auf behalten und beliebig wiederum verknüpfen, noch weniger aber ein anderes denkendes Subjekt sich unseren Versuchen der Absicht angemessen von uns unterwerfen läßt, und selbst die Beobachtung an sich schon den Zustand des beobachteten Gegenstandes alteriert und verstellt. Sie kann daher niemals etwas mehr als eine historische, und, als solche, so viel möglich systematische Naturlehre des inneren Sinnes, d.i. eine Naturbeschreibung der Seele, aber nicht Seelenwissenschaft, ja nicht einmal psychologische Experimentallehre werden.« (Kant Metaphysische Anfangsgründe der Naturwissenschaften, Vorrede, MAN, AA 04:471.22-32)

Hat sich das für Spencer-Brown in seiner eigenen psychotherapeutischen Erfahrung bestätigt? Lassen sich anders als Kant glaubt im Verhalten des Beobachters und des Beobachteten in der psychologischen Praxis Muster erkennen, die über die jeweilige Persönlichkeit hinausgehen? Mir ist nicht bekannt, ob und wie intensiv sich Spencer-Brown mit den Lehren etwa von Husserl, Heidegger, Sartre und anderen beschäftigt hat, die dieser Frage nachgegangen sind. Luhmann und Scheier stellen die Logik von Spencer-Brown in diesen Kontext und versuchen ihn von dort aus zu verstehen.

Hier erhält die Frage nach dem Re-entry eine neue Bedeutung. In der psychologischen und soziologischen Praxis ist Re-entry nicht einfach eine möglicherweise rein mechanische Resonanz, Feedback oder eine wie in selbst-referentiellen Systemen nahezu automatisch ablaufende Rückkopplung, sondern der Beobachtete bekommt vom Beobachter auf sein Verhalten eine Rückmeldung und reagiert darauf.

Prozess und Resultat

Wenn Spencer-Brown von seiner Berufserfahrung her das pragmatische Tun hervorhebt, stellt er damit das überlieferte Verhältnis von Prozess und Resultat in Frage. Da die traditionelle Logik nur zeitlose Aussagen kennt, die immer gelten und sich nie ändern, hat sie nicht die Logik von Prozessen untersucht. Für Aristoteles waren Logik und Physik klar getrennt. Die zeitlosen Aussagen hat er systematisch in den beiden Analytiken (Analytica protera und Analytiká hystera) untersucht, wogegen es in der Physik als der Lehre von den vergänglichen Dingen und Wesen, die Werden und Vergehen unterworfen sind, zu Zeit, Bewegung und Veränderung kommt (so auch der Titel seiner Schrift über das Werden und Vergehen, peri geneseôs kai phthoras). In der Physik bildete er mit energeia und entelecheia neue Begriffe, die nur für den Verlauf von Prozessen gelten und bewusst den Rahmen der Analytiken verlassen und einem neuen logischen Verständnis nahekommen. (Sie sind seither als Energie und Entelechie zu Grundlagenbegriffen in der Physik und Biologie geworden. Heidegger hatte sie als Existenzialien bezeichnet, es aber für unmöglich gehalten, für sie eine der traditionellen Logik vergleichbare Formalisierung zu finden.)

Spencer-Brown will die Logik begründen auf Begriffen, in denen Prozess und Resultat noch nicht klar getrennt sind. Dies Anliegen teilt er mit Hegel, der systematisch solche Begriffe benutzt hat. ‘Anfang’: Das kann sowohl der Vorgang des Anfangens wie das Resultat sein, das angefangen wurde. Ähnlich Bestimmung, Entwicklung, Messung usf.: Eine Messung kann der Vorgang des Messens sein, wie auch der Messwert, der gemessen wurde. Bestimmung kann der Vorgang des Bestimmens sein wie das Ergebnis, dass etwas so und nicht anders bestimmt ist.

Spencer-Brown gründet seine Logik mit Distinction (Unterscheidung) und Indication (Anzeige, Hinweis) auf ähnliche Begriffe. Das kann sowohl der Vorgang des Bezeichnens und Unterscheidens sein wie auch das Ergebnis, wenn eine Unterscheidung getroffen ist und eine Bezeichnung gefunden wurde. Es ist der Vorgang, etwas zu unterscheiden, und im Ergebnis das Zeichen (mark) und der Wert (value), der dem Etwas mit der Unterscheidung verliehen wird.

Wenn mit Begriffen begonnen wird, bei denen die Unterscheidung in Prozess und Resultat bewusst offen gehalten wird, dann muss es innerhalb der Logik einen klar erkennbaren und nachvollziehbaren Weg geben, dort Zeit und Bewegung einzuführen und diese Offenheit in ihre beiden Bestandteile auseinander zu legen. Dies Motiv sehe ich besonders in der Unterscheidung der primären Arithmetik und primären Algebra wie in der Einführung des Re-entry und der mit dem Re-entry gegebenen Zeit.

Die Zeichen und ihr Medium

Ist es für einen Mathematiker schon ungewohnt, die veränderte Bedeutung von Variablen im zeitlichen Verlauf von Zuweisungen in der Programmierung und der Logik von Spencer-Brown einerseits und den zeitlos gedachten mathematischen Gleichungen andererseits zu akzeptieren, so erfordert es ein noch weiter gehendes Umdenken, das Verhältnis von Zeichen und Medium als wechselseitigen Prozess anzusehen. Es ist für einen Mathematiker geradezu absurd anzunehmen, dass das Medium, in das die mathematischen Zeichen eingeschrieben sind, Einfluss auf die Zeichen und ihre Operationen nehmen könnte. Im Grunde stellt sich jeder Mathematiker die Zeichen seiner Formeln völlig unabhängig vom Medium vor, in dem sie dargestellt sind, am besten als Objekte in einem gänzlich immateriellen, rein geistigen Raum. Wenn er eine Tafel oder ein Blatt Papier oder einen Bildschirm braucht, um dort seine Formeln aufschreiben zu können, sind das nur Hilfsmittel ohne Einfluss auf die Inhalte des Rechnens und Beweisens. Es kann sein, dass eine Formel auf einem schlechten Hintergrund verschwimmt und daher falsch gelesen wird mit Ergebnissen, die in die Irre führen. Doch ist das nichts weiter als ein Störfaktor, der idealerweise ausgeschlossen werden kann. Die Aussagen mathematischer Sätze gelten prinzipiell unabhängig vom Medium, in dem sie aufgeschrieben werden.

Diese Einstellung ist 1948 mit der Arbeit von Claude Shannon (1916-2001) über die Mathematischen Grundlagen in der Informationstheorie erschüttert worden. Shannon war wie Spencer-Brown Mathematiker und Elektrotechniker. Er hat in seiner Untersuchung von Datenübertragungen nachgewiesen, wie jedes Medium ein Grundrauschen erzeugt, das die übertragenen Zeichen stört. Die Mathematik hat bis heute nicht wahrgenommen oder nicht wahrnehmen wollen, welche elementaren Konsequenzen sich daraus auch für die Mathematik und die Logik ergeben. Die Mathematik gilt bis heute als eine Lehre, die unabhängig vom Medium gilt, in dem sie geschrieben und über das sie übertragen wird. Niemand kann sich vorstellen, dass das Medium einen Einfluss auf die Zeichen und ihre Aussagen haben könnte. Mathematik gilt als eine Lehre, die im prinzipiell unbewegten Geist entwickelt wird.

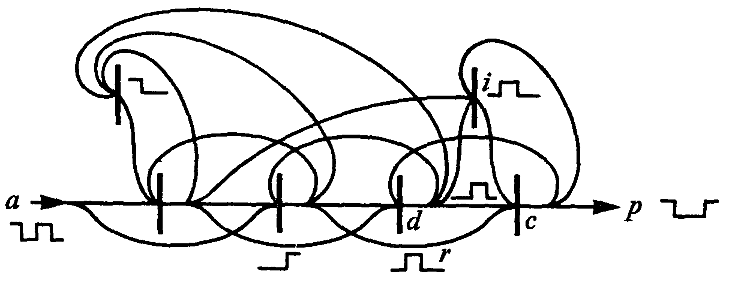

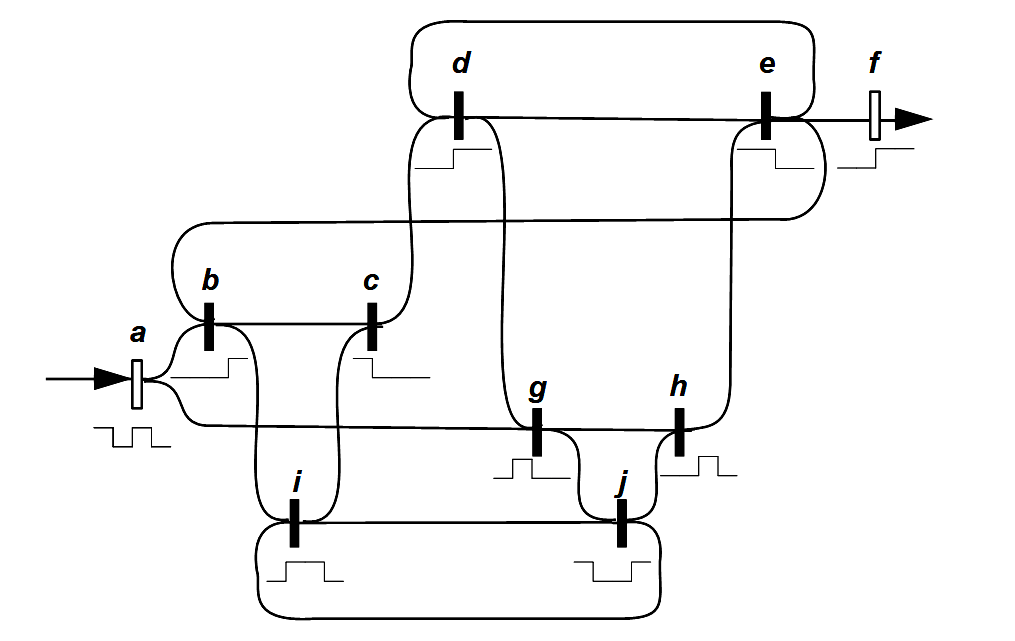

Für Spencer-Brown relativiert sich das. Für ihn kam mit dem Entwurf von Schaltkreisen eine prinzipiell neue Erfahrung hinzu, die noch weit über das bloße Programmieren hinausgeht. Schaltkreise sind auf den ersten Blick nichts anderes als eine graphische, anschauliche Formelsprache, die in ihrem logischen Status den Zeichen der Mathematik ähneln und ihnen letztlich entsprechen sollten. Doch zeigte sich für ihn bei den Schaltkreisen, die er entworfen und mit denen er gerechnet hat, dass jeder Schaltkreis eine Eigendynamik enthält, die die mit dem Schaltkreis entworfenen Aussagen und Ergebnisse mit tragen. Es lässt sich in Worten und Formeln beschreiben, welchen Input ein Schaltkreis verarbeitet und zu welchem Output er führt, aber es lässt sich nicht restlos erklären, wie es zu diesen Ergebnissen kommt. Offenbar enthält der Schaltkreis eine Art von Selbstorganisation, die aus sich heraus das Ergebnis beeinflusst. Wer einen Schaltkreis entwirft, hat zwar ein klares Ziel vor Augen und kann den Schaltkreis gestalten und realisieren, aber er kann nicht völlig voraussagen, was im Schaltkreis geschieht. Im Gegenteil verlässt er sich darauf, dass der Schaltkreis von sich aus eine Stabilisierung bewirkt, die dem Ergebnis erst die erwartete Sicherheit verleiht. Auch wenn sich bei näherer Untersuchung viele der Prozesse erklären lassen, die im Schaltkreis zum gewünschten Ergebnis geführt haben, bleibt immer ein Rest zurück. Diese Eigenschaft ergibt sich nicht aus der graphischen Gestalt und ihrer Formelemente, sondern aus dem Medium, in dem der Schaltkreis verwirklicht wird. Spencer-Brown vergleicht es mit der Chemie: Niemals kann mit chemischen Formeln vollständig beschrieben werden, was in einer chemischen Reaktion geschieht. Im realen chemischen Prozess steckt eine Eigendynamik, die trotz aller Vorkehrungen immer zu Überraschungen führen kann. Aus heutiger Sicht kann die Zellbiologie als weiteres Beispiel genannt werden. Es hat sich gezeigt, dass selbst die vollständige Aufschlüsselung des DNA-Codes nicht dazu führt, die Vorgänge in einer Zelle umfassend voraussagen zu können. In allen diesen Beispielen handelt es sich um Texte oder textähnliche Formen (die Graphik des Schaltplans, die chemischen Reaktionsgleichungen, der DNA-Code), die grundsätzlich unvollständig sind und das Medium, in dem sie realisiert werden, nicht vollständig abbilden können. Ist diese Erfahrung in einer Art von Grenzprozess auch auf die Mathematik und die Logik zu übertragen, oder zumindest dort geeignet zu berücksichtigen?

Das führt Spencer-Brown zur grundsätzlichen Frage nach dem Verhältnis der Zeichen und des Mediums. Das Ergebnis ist sicher nicht, dass die heute bekannte Mathematik »falsch« wird, weil sie ihr Medium und dessen Mitwirkung übersehen hat. Sondern das Ergebnis ist, dass die Mathematik vor dem Horizont einer übergreifenden Lehre von Medium und Zeichen zu verstehen ist, aus der heraus der besondere Status der Mathematik und die Bedingungen verständlich werden, warum sie in der uns bekannten Weise gilt.

Für mich ist dies das am schwersten zu verstehende und zugleich folgenschwerste Motiv von Spencer-Brown. Wird eine Logik entworfen, die selbstreflexiv ihr eigenes Medium versteht, in dem sie sich gründet, eingeschrieben ist und übertragen wird, dann kann das zum Entwurf einer Logik der medialen Moderne führen, die der heutigen Verfassung des Menschen gerecht wird. Auf den Stellenwert des Mediums zum Verständnis unserer Kultur hat insbesondere Scheier in Luhmanns Schatten hingewiesen. Spencer-Brown kann helfen, das weiter auszuarbeiten.

Neuronale Netze

Während die Paradoxa und Antinomien von Russell und Gödel bis in die Philosophie intensiv diskutiert werden, blieb die Entwicklung einer neuen Logik weitgehend unbeachtet, die von einem Aufschwung neurophysiologischer Forschungen ausging und zu den Neuronalen Netzen führte. Erst mit spektakulären Erfolgen wie dem Go spielenden Programm AlphaGo von 2015-16 ändert sich das schlagartig. Programme wie diese sind das Ergebnis einer inzwischen mehr als 100 Jahre andauernden Entwicklung. In dieser Tradition sehe ich auch Spencer-Brown.

Eine Schlüsselrolle spielte Warren McCulloch (1898-1969). Er studierte Philosophie, Psychologie und Medizin, arbeitete vor allem als Neurophysiologe und sieht sich sowohl in der Tradition der schon immer praktisch orientierten und pragmatisch denkenden amerikanischen Philosophie wie auch der um 1900 entstehenden Neurophysiologie. Von der amerikanischen Philosophie nennt er insbesondere Charles Sanders Peirce (1839-1914) und Josiah Willard Gibbs (1839-1903), sodann auf sie aufbauend die Diskussion während der 1940er mit Norbert Wiener (1894-1964), Arturo Rosenblueth (1900-1970), John von Neumann (1903-1957) und Walter Pitts (1923-1969). Die meisten von ihnen haben sich sicher eher als Fachwissenschaftler denn als Philosophen verstanden, weil sie von der Philosophie ihrer Zeit keine anregenden Impulse mehr erwarteten. Viele von ihnen blieben bewusst außerhalb des akademischen Bereichs bzw. wurden dort nicht aufgenommen (so Norbert Wiener). Wenn es dennoch zu tiefen philosophischen Fragen und Gesprächen kam, ist das vor allem McCulloch zu verdanken.

McCulloch hatte über Jahrzehnte mit immer neuen Ansätzen nach einer neuen Logik gesucht, die über die Tradition von Aristoteles bis Frege und Russell hinausgeht. 1920 wollte er die in allen klassischen Aussagen nach dem Muster ›S ist P‹ auftretende Copula ‘ist’ erweitern in drei Gruppen von Verben: (i) Verben, die von einem Objekt zu einem Subjekt führen und aus der Vergangenheit kommen, während die Copula ‘ist’ nur in einer zeitlosen Gegenwart auftritt; (ii) Verben, die von einem Subjekt zu einem Objekt und damit in die Zukunft führen; (iii) Verben, die einen andauernden Zustand beschreiben. Doch führte das nicht zum Erfolg. Es folgten Bemühungen, für das psychische Denken auf ähnliche Weise nach kleinsten Einheiten zu fahnden, wie es der Physik mit den Elektronen, Photonen und anderen physikalischen Elementen gelungen war: Er nannte sie Psychone. Sie sollten in anderer Weise als die traditionellen Objekte und Beziehungen der Logik miteinander verknüpft sein, um mit ihnen das psychische Geschehen und die von der Psychiatrie untersuchten Krankheiten darstellen und Therapien finden zu können. Auch das lieferte nicht die gewünschten Ergebnisse. Die Wende kam erst, als er mit den Arbeiten der Neurophysiologie vertraut wurde und sich aktiv als Forscher an dieser Richtung beteiligte. Er sah von Anfang an die Möglichkeit, mit ihnen der transzendentalen Logik von Kant einen neuen Boden zu geben (wenn das Netzwerk von den Sinnesorganen zum Gehirn an die Stelle der transzendentalen Apperzeption tritt und die Vorprägung aller sinnlichen Reize erklärt, bevor es zum Denken in Vorstellungen und Begriffen kommt). An seinem Lebensende veröffentlichte er einen Sammelband wichtiger Arbeiten mit dem programmatischen Titel Verkörperungen des Geistes. Er nahm 1946-1953 federführend an den Macy-Konferenzen teil. Viele Ideen waren im Verlaufe des 2. Weltkriegs im Rahmen des 1941 vom US-Präsidenten Roosevelt gegründeten Office of Strategic Services (OSS) entstanden, an dem auch Marcuse, Bateson, Sweezy und andere Vertreter der späteren Neuen Linken mitarbeiteten. Nach 1945 ging aus dem OSS zum einen der CIA hervor, zum anderen suchten viele Beteiligte nach einer Fortführung ihrer Arbeit im Rahmen einer zivilen Anwendung. Sie waren überzeugt am Beginn einer völlig neuen Entwicklung zu stehen.

Bereits 1931 hatte McCulloch von den neuen Arbeiten von Kurt Gödel (1906-1978) erfahren und beschäftigte sich von Anfang mit den Ergebnissen von Alan Turing (1912-1954), die seit 1937 veröffentlicht wurden. Dort war der Beginn einer völlig neuen Art von Logik zu erkennen, und es ist ohne Zweifel die besondere Leistung von McCulloch, die Vielfalt dieser Strömungen miteinander in Verbindung gebracht zu haben.

Der Durchbruch kam für ihn mit der Neurophysiologie. Sie nahm ihren Anfang mit dem Mediziner Ramón y Cajal (1852-1934). Von ihm stammen die ersten Diagramme von Sinnesorganen und den von ihnen ausgehenden Nervenbahnen, die er aus gründlichen Untersuchungen des Nervensystems und dem Sezieren von Fröschen und anderen Tieren gewonnen hatte. Der Mediziner, Psychiater und Psychoanalytiker Lawrence Kubie (1896-1973) beschrieb an ihrem Beispiel 1930-41 erstmals Schaltkreise, geschlossene Nachhall-Kreise (closed reverberating circuits), um das Gedächtnis zu verstehen.

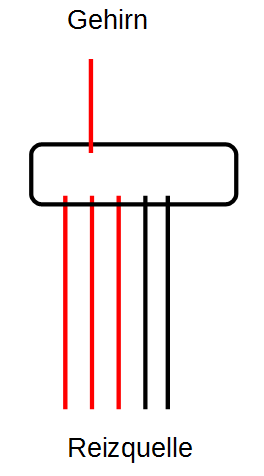

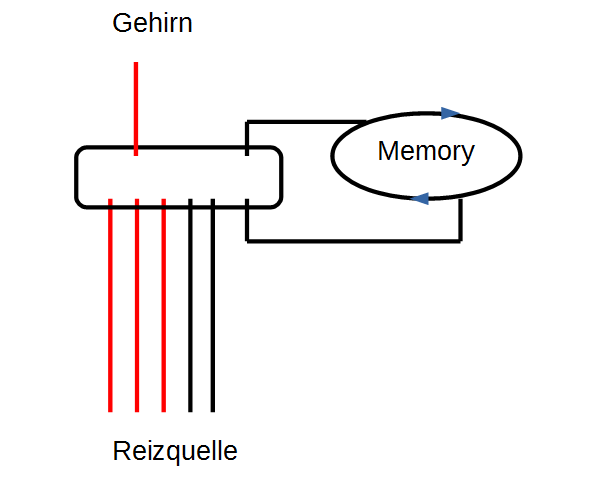

Für mich sind in Hinblick auf Spencer-Brown vor allem zwei Ergebnisse wichtig: Am Beispiel der Nervenbahnen vom Froschauge zum Froschgehirn wurden zwei wichtige Prinzipien erkannt, die indirekt in den Gesetzen der Form nachwirken.

Prinzip der Additivität: Erst wenn ausreichend viele Nervenbahnen einen Input melden, wird er zum Gehirn weiter geleitet. Einzelne, isolierte Inputs werden dagegen ignoriert. Wenn die Selektion nicht funktioniert, wird das Gehirn gleichsam überschwemmt und darüber überfordert. Das ist eine Ursache für Epilepsie.

Gedächtnis: Zusätzlich wird bei Überschreiten einer Grenzschwelle ein Kreisel eingerichtet. Dort läuft eine Information im Kreis und jede Wiederkehr erinnert daran, dass es ursprünglich einen Reiz gab, der diesen Kreislauf ausgelöst hat. Der aktivierte Kreis merkt sich, dass etwas geschehen ist. Er dient im Nervensystem als zusätzlicher Input. Mit ihm wird nicht nur gemeldet, dass ausreichend viele Nervenbahnen vom gleichen Ereignis angeregt wurden, sondern dass dieses Ereignis bereits in der Vergangenheit stattgefunden hat. Das ist die technische Grundlage und Realisierung eines lernenden Systems.

Auf ähnliche Weise spricht Spencer-Brown von der memory function und stellt sie durch geschlossene Schaltkreise dar. Spencer-Brown hat eine abstraktere Ebene gesucht, die in den Rahmen einer Logik passt. Mir ist nicht bekannt, ob er sich ausdrücklich auf diese Tradition bezogen hat, aber für mich ist deutlich, wie er in dieser Tradition steht. Er hat diese Ideen nicht mehr ausarbeiten können, aber sie tauchen an entscheidenden Stellen in den Gesetzen der Form auf. In England war er möglicherweise stärker von dem 1948 vorgestellten Homöostaten beeindruckt als von der Neurophysiologie. Urheber war der englische Psychiater und Biochemiker William Ross Ashby (1903-1972). Spencer-Brown hat auf eigenartige Weise in seine Ausführungen zum Re-entry und zu Schaltkreisen (circuits) Elemente der neuen Erkenntnisse der Neurophysiologie aufgenommen, ohne das klar wird, welche Intuition ihn geleitet hat.

McCulloch hatte 1945 in einem kurzen, aber grundlegenden Artikel Heterarchie und Hierarchie auf grundlegende philosophische Aspekte der neuen Schaltkreise hingewiesen, die im Rahmen der ersten Ideen für neuronale Netze entstanden. In einem Netzwerk gibt es kein steuerndes, hierarchisches Zentrum mehr, sondern eine Heterarchie nebenläufiger und zirkulär miteinander verbundener Entwicklungen. Das scheint mir die Grundidee zu sein, die wiederum Niklas Luhmann (1927-1998) in seinen Arbeiten zur Systemtheorie aufgenommen hat – auch wenn er nur sehr am Rande auf McCulloch Bezug nimmt (so in Soziale Systeme, Frankfurt am Main 1984, 565 und Wissenschaft der Gesellschaft, Frankfurt am Main 1990, 365), und warum er hoffte, mit Spencer-Brown seiner Systemtheorie eine neue logische Basis geben zu können, die sich von der traditionellen Subjektphilosophe und deren Paradoxien unterscheidet.

Der gordische Knoten

Ist es möglich, alle diese Fragen gemeinsam wie in einem gordischen Knoten zu lösen? Das scheint mir letztlich das Motiv von Spencer-Brown zu sein.

Spencer-Brown stellt als Motto einen Vers aus dem Daodejing von Lao-Tse voran. Lao-Tse beginnt seine Schrift mit vier Versen, von denen Spencer-Brown den dritten Vers ausgewählt hat.

Wu ming tian di zhi shi

Nichts/Ohne Name Himmel Erde von Anfang

»Da das Chinesische eine isolierende und keine flektierende Sprache ist, gehört zu dem chinesischen Satz eine Ambiguität, die in den westlichen Sprachen durch die Entscheidung für eine Wortart verloren geht. Die Ambiguität hängt an der grammatischen Rolle des ersten Wortes wu: nicht, ohne, Nichts.« (SWH, 65)

Der Vers kann daher in zweierlei Weise übersetzt werden:

– Ohne Name ist der Anfang des Himmels und der Erde

– 'Nichts' ist Name des Anfangs von Himmel und Erde.

Alle vier Verse lauten im Zusammenhang:

Der Weg, der wirklich Weg ist, ist ein anderer als der unwandelbare Weg.

Die Namen, die wirklich Namen sind, sind andere als unwandelbare Namen.

Namenlos/Nichts ist der Anfang von Himmel und Erde.

Der Name ist die Mutter der zehntausend Dinge. (zitiert SWH, 65)

»Distinction is Perfect Continence«

Irgenwo muss auch Spencer-Brown in seiner Logik mit nicht weiter hinterfragbaren Grundbegriffen anfangen. Er sucht sie noch unterhalb der gewöhnlichen Mathematik und Sprache. Vor jedem Sprechen und Rechnen stehen für ihn Indication (Hinweis) und Distinction (Unterscheidung). Mit ihnen möchte er eine Proto-Logik und Proto-Mathematik begründen, einen Kalkül der Indikation und Distinktion.

»We take as given the idea of distinction and the idea of indication. We take, therefore, the form of distinction for the form.« (LoF, 1)

Ohne Unterscheidungen getroffen zu haben, sind weder Sprache noch Rechnungen möglich: Um rechnen und Sätze bilden zu können, müssen bereits im Vorfeld die beim Rechnen und Schreiben verwendeten Zeichen voneinander unterschieden sein. In einer Gleichung wie ›2 + 3 = 5‹ werden Operanden (in diesem Beispiel die Zahlen 2, 3 und 5) und Operatoren (Operationszeichen) (hier + und = für Addition und Gleichsetzung) verknüpft und aus ihnen eine Aussage gebildet. Ähnlich ist es in der Sprache. In einem Satz wie ›S ist p‹ sind S und p als Operanden und die Copula ‘ist’ als Operator zu verstehen. Die Zeichen 2, 3, 5, + und = müssen voneinander unterscheidbar sein, und es muss vorausgesetzt werden, dass sie sich während der Rechnung nicht ändern. Wäre das nicht möglich, dann wäre die Gleichung sinnlos. Daher liegt es nahe, die Proto-Operation des Unterscheidens noch vor den Operationen des Rechnens und Sprechens anzusetzen und aus ihr schrittweise die übliche Logik und Arithmetik zu entwickeln.

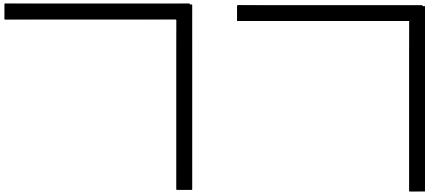

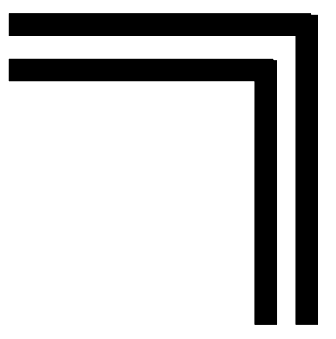

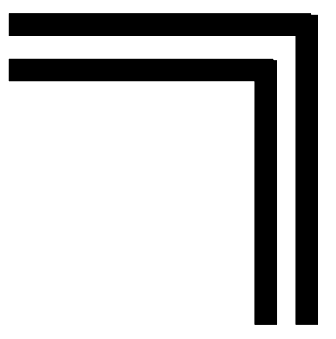

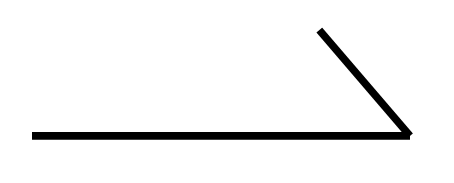

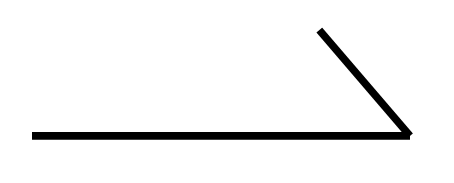

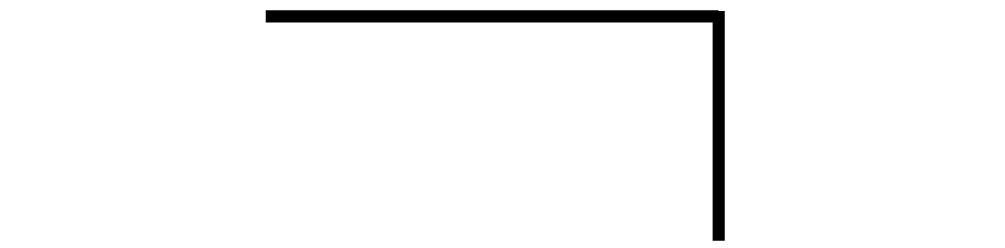

Für Spencer-Brown muss es ein Zeichen geben, dass diese Ebene trifft und den bekannten Zeichen für Operanden (Zahlen und Buchstaben) sowie Bindeverben (Satzbändern wie z.B. die Kopula ‘ist’ und Rechensymbolen wie +) vorausgeht. Er geht noch weiter: Er sucht ein Zeichen, dass sogar der Unterscheidung in Operanden und Operatoren vorausgeht und sowohl als Operator wie als Operand dienen kann. Dies elementare Zeichen ist für ihn der Haken (Winkel, cross):

Dies Zeichen hat eine vielfache Bedeutung:

– Ausführung einer elementaren Operation (das Zeichnen dieses Zeichens, draw a distinction)

– Hervorheben eines Inneren (mark)

– Auszeichnen eines inneren Bereichs (marked space) (Asymmetrie von Innen und Außen)

– Ziehen einer Grenze (boundary with separate sides)

– Unterscheiden eines Grundes vom Zeichen, das in den Grund gezeichnet ist (ground, medium)

– Benennen der Grenze durch das Zeichen ⃧ (indication, call)

In der letztgenannten Bedeutung ist es selbst-bezüglich: Es zeigt sowohl mit seiner äußeren Gestalt anschaulich den Unterschied zwischen einem Innen und einem Außen, und zugleich ist dies Zeichen der Name für diesen Unterschied. Dadurch wird dem Innen ein Wert verliehen.

Das Verblüffende ist nun, dass mit diesem einzigen Zeichen nicht nur die Operanden, sondern auch die Operatoren dargestellt werden können. Spencer-Brown unterscheidet nicht wie die traditionelle Logik und Mathematik zwischen Zeichen für Operanden und Operatoren, sondern definiert die Operationen (das Rechnen und die Bildung von Aussagen) implizit durch die bloße Anordnung der Operanden: Das sind die beiden Operationen ‘Wiederholung’ und ‘Verschachtelung’. Mit ihnen lässt sich die weitere Logik vollständig aufbauen.

Alle weiteren Zeichen werden schrittweise aus diesen beiden Zeichen und ihren beiden Anordnungsmöglichkeiten zusammengesetzt, so wie in der euklidischen Geometrie alle Konstruktionen aus Geraden und Kreisen hervorgehen.

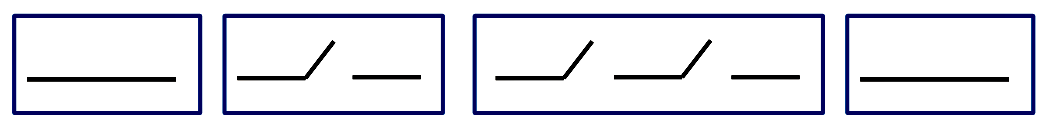

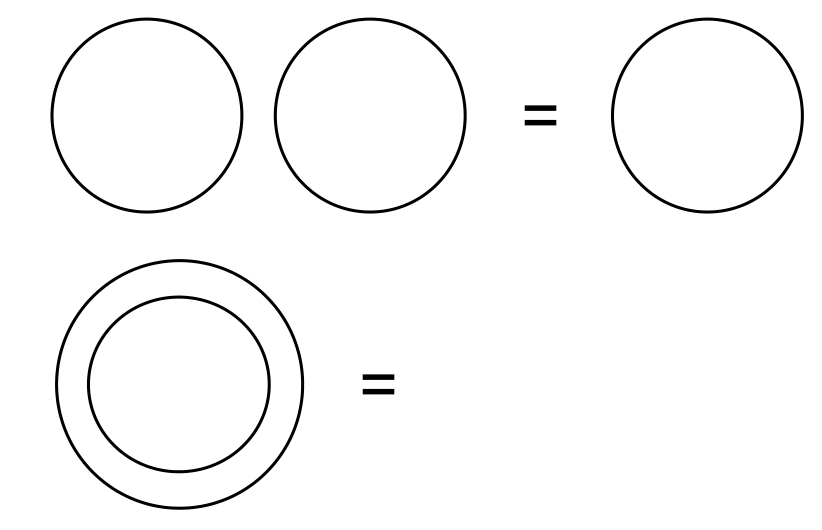

Für diese beiden Operationen setzt Spencer-Brown zwei Axiome:

»Axiom 1: The law of calling.

The value of a call made again is the value of the call.« (LoF, 1)

⃧ ⃧ = ⃧

lies: Wird etwas zweimal bei seinem Namen genannt, ändert sich der Name dadurch nicht.

»Axiom 2: The law of crossing

The value of crossing made again is not the value of the crossing« (LoF, 2)

= .

= .

lies: Wird zweimal die Grenze gewechselt, dann wird der Anfangszustand wiederhergestellt. Die Wiederholung des Crossing hat einen anderen Wert als das einfache Crossing. Das liegt daran, dass zwischendurch eine Umkehr erfolgt. Beim Crossing wird die Seite gewechselt, beim Recrossing wird diese Aktion rückgängig gemacht.

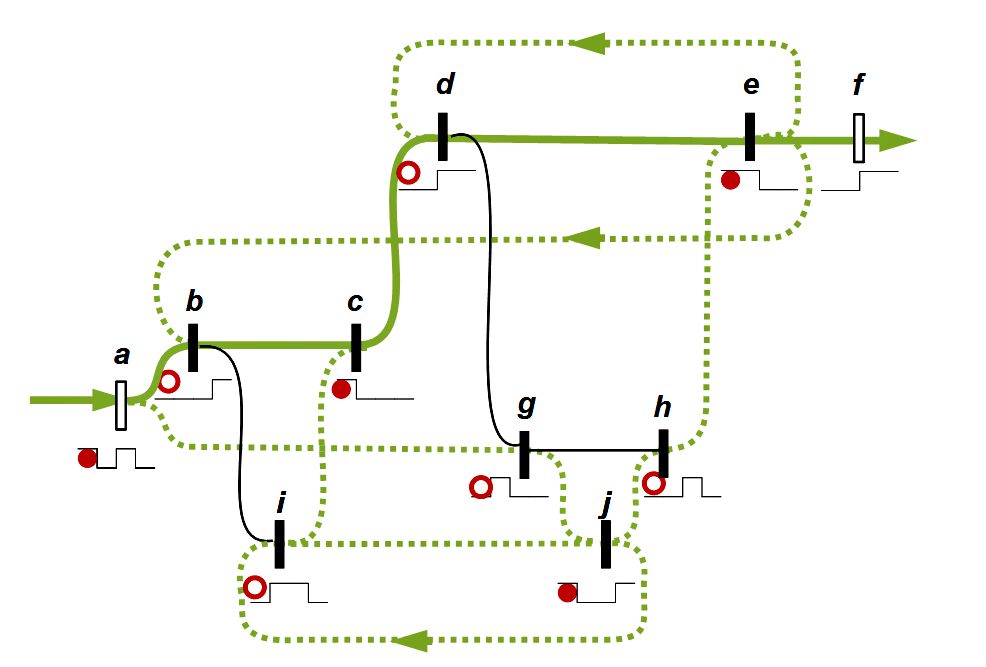

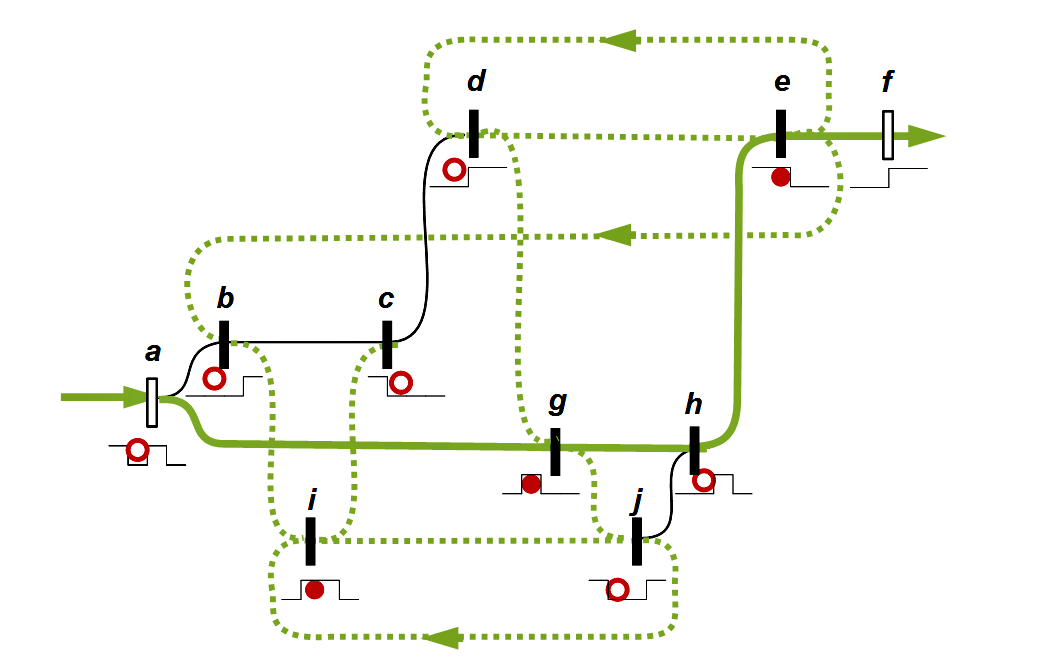

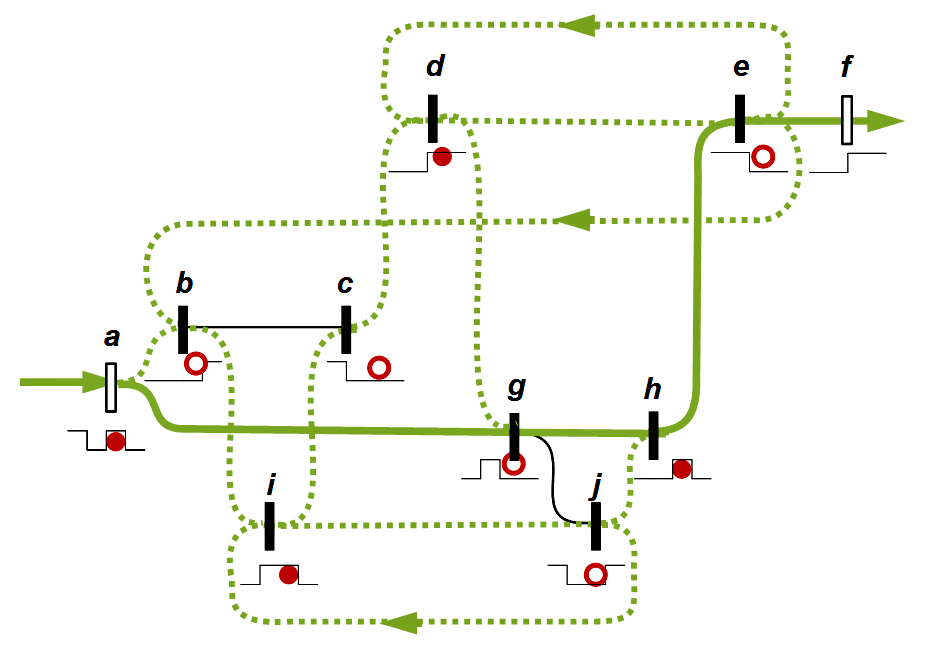

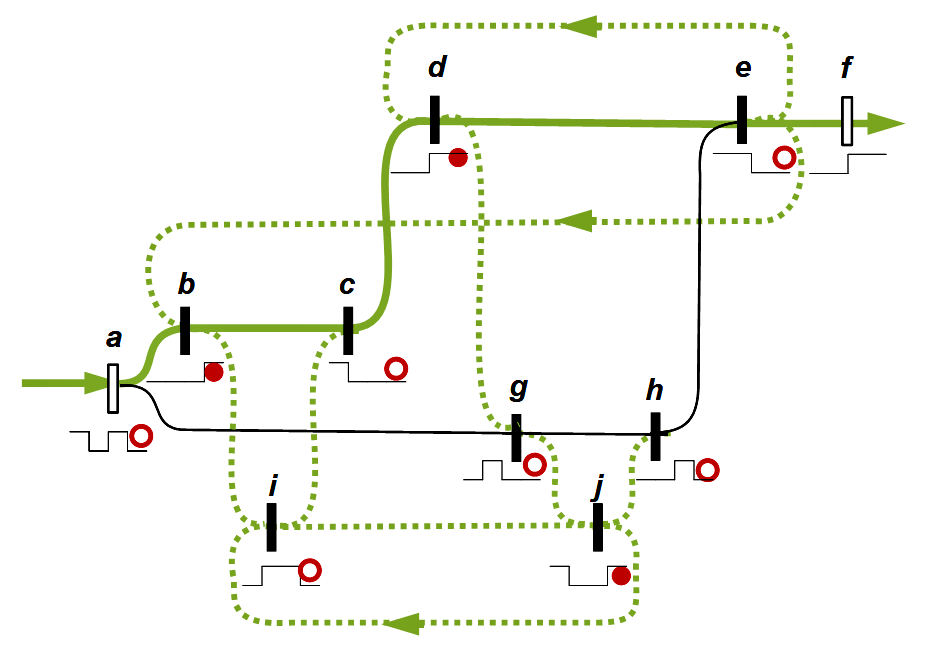

Die Einführung dieser beiden Axiome wird vielleicht verständlicher, wenn daran erinnert wird, dass Spencer-Brown von Schaltkreisen ausging. (1) Wird in einem Schaltkreis auf einer Verbindung ein Schalter geöffnet, dann ist die Strecke unterbrochen und wechselt vom Zustand ‘an’ in den Zustand ‘aus’. Werden mehrere Schalter geöffnet, bleibt der Zustand ‘aus’ erhalten. Es ist im Ergebnis das gleiche, einen Schalter oder mehrere Schalter zu öffnen. (2) Wird ein Schalter erst geöffnet und dann wieder geschlossen, ist der Ursprungszustand ‘an’ wieder hergestellt.

Mit Axiom 2 ist implizit das Medium eingeführt: Wird das Recrossing als Reflexion verstanden, mit der im wörtlichen Sinn eine Grenzüberschreitung reflektiert (zurückgeworfen) wird, dann entsteht mit Axiom 2 als Ergebnis der leere Raum. Er ist das, was übrig bleibt, wenn etwas unternommen und wieder rückgängig gemacht wird. Was zurück bleibt ist nicht mehr einfach das Nichts: Es ist der Raum, der durch die zweifache Bewegung eines Werdens und eines Vergehens entstanden ist: Die Grenze wurde zuerst gezeichnet. Das ist ein Werden. Sodann wurde das Werden durch ein Vergehen rückgängig gemacht. Übrig bleibt der Grund, auf dem diese Bewegung von Werden und Vergehen stattgefunden hat. – Oder anders gesagt: Ein Beobachter sieht zwar nichts mehr, aber er kann sich an die Bewegung des Crossing und Recrossing erinnern. In seinem Gedächtnis kann eine Spur zurückbleiben, auf die sich die Erinnerung stützt. (Vergleiche hierzu die Ausführungen von Hegel: »Das Resultat ist das Verschwundensein, aber nicht als Nichts.« HW 5.113)

Mit Werden und Vergehen der Grenze im Crossing und Recrossing ist implizit von Anfang an die Zeit gesetzt. Sie ist bereits in der ursprünglichen Aufforderung enthalten »triff eine Unterscheidung, draw a distinction«. Spencer-Brown ist noch konsequenter als Hegel: Er wählt nicht nur wie Hegel Begriffe, die zugleich eine Bewegung wie ihr Resultat beschreiben (Unterscheidung, Bezeichnung kann sowohl verstanden werden als das Unterscheiden und Bezeichnen wie auch als das Ergebnis, die mit dem Unterscheiden und Bezeichnen erreichte Unterscheidung und Bezeichnung), sondern er wählt mit dem Haken ein Zeichen, das zugleich die Operation (Bewegung) wie den Operand beschreibt.

Anmerkung: In den beiden Operationen der Wiederholung (Recalling) und der Rückkehr zurück über die Grenze (Recrossing) sehe ich formal die beiden von Hegel unterschiedenen Bewegungen der Kontinuation und der Umkehr, die für mich zentral sind für das Verständnis sowohl der absoluten Indifferenz, wie des Übergangs von der Seinslogik zur Wesenslogik und im Weiteren des Begriffs der Idee (siehe hierzu den Beitrag Idee des höheren Widerspruchs).

Aber wie soll das Zeichen ⃧ im Deutschen benannt werden? Spencer-Brown führt es ein als »crossing the boundary« und als »calling« (LoF, 1), und nennt es nach dem ersten Aufzeichnen ein »mark« (LoF, 3). In deutschen Übersetzungen wird bisweilen das englische Wort ‘cross’ beibehalten oder ein neutraler Ausdruck gewählt wie ‘Token’, ‘Markierung’ oder ‘Zeichen’. Die wörtliche deutsche Übersetzung ‘Kreuz’ wird meist vermieden, da es sich äußerlich nicht um ein Kreuz  , sondern um einen Winkel handelt. Ein Winkel wird jedoch meist nach rechts geöffnet und mit einer Öffnung von weniger als 90° vorgestellt, so auch das Zeichen für Winkel in der Auszeichnungssprache HTML: ∠. Möglich ist auch das Wort ‘Haken’. Das alles trifft jedoch nicht die von Spencer-Brown gemeinte Doppelbedeutung eines Zeichens und einer Bewegung (cross, crossing, in deutscher Übersetzung: Kreuz und Kreuzen). Auch das Wort ‘Quere’ ist missverständlich, denn unter einer Quere ist eher ein Zeichen wie \ oder / zu verstehen, das quer verläuft, und mit Überqueren ist oft eine andere Art von Bewegung gemeint, etwa das Überqueren eines leeren Platzes, eines Flusses, eventuell auch eine Abkürzung, wenn ein Rechteck entlang der Diagonale durchquert wird. Trotz Bedenken ist für mich in Gesprächen und bei Demonstrationen an einer Tafel der Name ‘Haken’ am eingängigsten, weil er am besten die äußere Gestalt trifft. In der englischen Übersetzung behalte ich trotz aller Bedenken den Ausdruck ‘cross’ bei, da er in den Arbeiten zu Spencer-Brown am weitesten verbreitet ist.

, sondern um einen Winkel handelt. Ein Winkel wird jedoch meist nach rechts geöffnet und mit einer Öffnung von weniger als 90° vorgestellt, so auch das Zeichen für Winkel in der Auszeichnungssprache HTML: ∠. Möglich ist auch das Wort ‘Haken’. Das alles trifft jedoch nicht die von Spencer-Brown gemeinte Doppelbedeutung eines Zeichens und einer Bewegung (cross, crossing, in deutscher Übersetzung: Kreuz und Kreuzen). Auch das Wort ‘Quere’ ist missverständlich, denn unter einer Quere ist eher ein Zeichen wie \ oder / zu verstehen, das quer verläuft, und mit Überqueren ist oft eine andere Art von Bewegung gemeint, etwa das Überqueren eines leeren Platzes, eines Flusses, eventuell auch eine Abkürzung, wenn ein Rechteck entlang der Diagonale durchquert wird. Trotz Bedenken ist für mich in Gesprächen und bei Demonstrationen an einer Tafel der Name ‘Haken’ am eingängigsten, weil er am besten die äußere Gestalt trifft. In der englischen Übersetzung behalte ich trotz aller Bedenken den Ausdruck ‘cross’ bei, da er in den Arbeiten zu Spencer-Brown am weitesten verbreitet ist.

Für das andere Zeichen, das nur aus einer Leere besteht, hat Spencer-Brown lange nach einem geeigneten Namen gesucht. Erst in der 2. Auflage der deutschen Übersetzung von 1999 führt er den Ausdruck Ock ein.

»Kurz nachdem es das erstemal veröffentlicht wurde, erhielt ich einen Telephonanruf von einem Mädchen namens Juliet, die, während sie ihre Begeisterung über das, was ich getan hatte, ausdrückte, ebenso ihrer Frustration Ausdruck verlieh, nicht den leeren Raum über das Telephon sprechen zu können. [...] Sie hatte völlig recht, und ich erfand in der Folge das Wort Ock (vom Indoeuropäischen okw = das Auge), symbolisiert durch einen umgekehrten Kleinbuchstaben Ɔ um in einer sprechbaren Form die universelle rezessive Konstante zu kennzeichnen, die alle Systeme gemeinsam haben. Gewöhnliche Zahlensysteme haben natürlich zwei Ocks, null für die Addition und die Einheit für die Multiplikation. [...] In diesem Buch, in dem seine wahre Natur erstmals klargemacht wurde, war es aber wichtig, das Ock namenlos und leer zu lassen, weil es das nächste war, an das ich gelangen konnte, um hervorzuheben, daß es überhaupt nichts ist, nicht einmal leer. Seine Erfindung war mächtiger als die Erfindung der Null, und sandte Schockwellen durch die gesamte mathematische Gemeinde, die selbst jetzt noch nicht abgeklungen sind.« (Spencer-Brown, 1999, xvf, zitiert bei Rathgeb, 118)

In der Sekundärliteratur zu Spencer-Brown ist das bis heute außer bei Rathgeb nicht aufgenommen worden. Aber ich werde mich ihm im Folgenden anschließen, da mir das die einfachste und beste Weise scheint, die beiden Grundzeichen in Worten zu benennen.

Zusammenfassung: Das Anliegen dieser ersten Schritte nennt Spencer-Brown:

»Definition

Distinction is perfect continence.« (LoF, 1)

Was ist mit dem ungewöhnlichen Wort continence gemeint: SWH erläutern: (a) Es kann Enthaltsamkeit, Mäßigkeit und Selbstkontrolle bedeuten (kontinent als Gegenteil von inkontinent). In dieser Bedeutung wird mit continence gesichert, dass etwas nicht auseinanderläuft und sich zerstreut, verfranst und die eigene Identität verliert. (b) Und es kann Zusammenhalt bedeuten im Sinne des Kontinuum, wodurch zum Beispiel in der Geometrie die Unendlichkeit von Punkten auf einer Linie zusammengehalten wird. (SWH, 70) Das scheint mir das Anliegen von Spencer-Brown sehr gut zu treffen.

Proto-Arithmetik und Proto-Algebra

Spencer-Brown hat sein Verständnis von Arithmetik und Algebra auf der AUM-Konferenz in der Session Two am 19.3.1973 dargelegt und zur Diskussion gestellt.

– Eine Arithmetik wird demonstriert an physischen Gegenständen. Schon im Kindergarten oder der Grundschule wird sie an Beispielen gelernt wie ›3 Äpfel und 2 Äpfel sind 5 Äpfel‹. Jeder kann die beiden kleineren Mengen von 2 und von 3 Äpfeln nehmen, sie zusammenlegen und nachzählen, dass es jetzt 5 Äpfel sind. Beispiele dieser Art sind so intuitiv und "schlagend", dass kaum jemand bemerkt, was implizit vorausgesetzt und unter der Hand mitgelernt wird. Die einzelnen Äpfel bleiben selbständig und verändern sich nicht durch das Zählen. Würden sie wie bei einem chemischen Prozess miteinander reagieren und verschmelzen oder sich in andere Objekte umwandeln oder aufteilen, dann wäre das Zählen unmöglich. Spencer-Brown formuliert daher eigene Regeln, die das sicherstellen (die von ihm so genannten Kanons).

Erst allmählich wird daraus das abstrakte Rechnen mit Zahlen, bei dem nicht mehr ausdrücklich auf bestimmte Gegenstände hingewiesen wird. Die Zahlen selbst sind keine physischen Gegenstände. In der Schule wird das implizit mitgelernt, und es ist bis heute eine unentschiedene Frage, ob die Zahlen unabhängig von den gezählten Gegenständen bestehen, ob sie eine der Eigenschaften der gezählten Gegenstände sind, oder ob es die Zahlen nur im Denken von vernunftbegabten Wesen wie den Menschen gibt, die im Laufe ihrer Entwicklung Zahlen eingeführt haben und mit ihnen in Gedanken operieren können. Die Philosophen und Logiker haben hierüber nie Einigkeit erzielt. Ich schließe mich der Ansicht von Aristoteles an, für den die Zahlen nur im Denken bestehen.

In welcher Weise kann in der Proto-Arithmetik von Proto-Zahlen gesprochen werden, und wie lassen sie sich vergleichbar dem Zählen von Äpfeln an konkreten Gegenständen veranschaulichen? Spencer-Brown geht eine Ebene tiefer und versteht die beiden Zeichen ⃧ und Ɔ (Ock) in einer doppelten Bedeutung, in der sie sowohl als Zahlen wie als Operationszeichen dienen. Die gewöhnliche Arithmetik kennt Ausdrücke wie ›7 + 5‹ oder ›120 − 13‹. Für Spencer-Brown handelt es sich bei ihnen um Zeichenketten, die nach festen Regeln aus einem bestimmten Zeichenvorrat gebildet werden, der im Dezimalsystem aus den Ziffern 0, 1, 2, …, 9 und den Operationszeichen wie + und − besteht. In seiner Proto-Arithmetik reduziert er den Zeichenvorrat auf die beiden Zeichen ⃧ und Ɔ (Ock), aus denen die arithmetischen Ausdrücke zusammengesetzt werden. Genau genommen sind sie weder Proto-Ziffern noch Proto-Zahlen, sondern mathematische Proto-Zeichen, aus denen mathematische Ausdrücke gebildet werden, in denen sie sowohl die Bedeutung von Ziffern (und den aus ihnen nach dem Stellenwertsystem zusammengesetzten Zahlen) als auch von Operationszeichen erhalten. Um die Ausdrucksweise nicht zu kompliziert werden zu lassen, kann dennoch von Proto-Zahlen gesprochen werden, auch wenn das wörtlich genommen falsch ist. Spencer-Brown sagt, dass die Proto-Arithmetik mit ihnen rechnet (calculates, siehe das Kapitel Calculation; LoF, 11). Aus den beiden Zeichen ⃧ und Ɔ (Ock) werden nach den beiden Regeln der Mehrfach-Ausführung und Verschachtelung komplexere Zeichen zusammengesetzt. Das sind in einem ungenauen Sinn die Proto-Zahlen. Spencer-Brown spricht nicht von Rechenoperationen, sondern von Umwandlungen (»primitive equations«, »procedue«, »changes«; LoF, 10f) und führt hierfür das Zeichen ⇀ ein (LoF, 8). Mit diesem Zeichen werden zwei arithmetische Ausdrücke voneinander getrennt. Es bedeutet, dass der zweite Ausdruck durch eine Umwandlung aus dem ersten Ausdruck hervorgegangen ist (LoF, 11).

Die gewöhnlichen Zahlen werden als Abstraktion aus dem Zählen von Gegenständen veranschaulicht und verstanden. Mit den beiden Zeichen ⃧ und Ɔ werden im ersten Schritt noch nicht Gegenstände gezählt, sondern unterschieden. Das Unterscheiden geht dem Zählen voraus. Wenn Gegenstände nicht unterschieden werden (nicht sortal sind), können sie auch nicht gezählt werden. Das Zeichen ⃧ beschreibt, dass es einen Unterschied von etwas zu etwas anderem gibt, und das nur als leere Fläche gedachte Zeichen Ɔ beschreibt den Hintergrund, vor dem sich die Grenze eines Etwas von seinem Äußeren abhebt. Der Abstraktionsprozess bleibt jedoch ähnlich: So wie aus dem Zählen von Gegenständen das Verständnis der Zahlen gewonnen wird, so wird aus dem Unterscheiden von Gegenständen voneinander und vor dem jeweiligen Hintergrund das Verständnis der beiden Zeichen ⃧ und Ɔ gewonnen.

So wie die herkömmliche Arithmetik die natürlichen Ziffern 0, 1, 2, 3, …, 9 einführt und mit ihnen Zahlen bildet und rechnet, sieht Spencer-Brown seine primary arithmetic als eine vereinfachte und vorlaufende Arithmetik an, die nur die beiden Zeichen ⃧ und Ɔ (Ock) kennt. Mit diesen beiden Zeichen soll auf eine vergleichbare Art gerechnet werden, wie wir es aus der gewöhnlichen Arithmetik gewohnt sind, um tieferliegende arithmetische Zusammenhänge zu erkennen, aus denen schrittweise die gewöhnliche Arithmetik hergeleitet werden kann.

– Die Arithmetik berücksichtigt die Individualität der jeweiligen Zahlen. In der Zahlentheorie ist jede einzelne Zahl etwas Besonderes. Was in der Arithmetik für eine bestimmte Zahl bewiesen wurde, lässt sich nicht ohne Weiteres auf die anderen Zahlen übertragen. Erst die Algebra wird Regeln studieren, die grundsätzlich für alle Zahlen gelten. So ist es auch bei der Proto-Arithmetik, mit der die Besonderheiten der beiden Zeichen ⃧ und Ɔ (Ock) sowie der aus ihnen zusammengesetzten Zeichen untersucht werden.

Spencer-Brown will zurückkehren zu dem ursprünglichen Zahlenverständnis, das in der Arithmetik enthalten ist und der Algebra vorausgeht. Wer das Rechnen und den Umgang mit Zahlen lernt, wird anfangs jede Zahl in ihrer Besonderheit erfassen. Jede neue Zahl hat etwas Eigenes. Kinder lernen, wie z.B. die Zwei und die Vielfachen von Zwei, die Drei und die Vielfachen von Drei, die Fünf und die Vielfachen von Fünf jeweils etwas Besonders haben. So haben z.B. alle Vielfachen von Fünf als letzte Ziffer nur die 0 oder die 5 (5, 10, 15, 20, …), bei den Vielfachen der 3 ist die Quersumme durch 3 teilbar (die Quersumme ist die Summe aller Ziffern, z.B. wird die Quersumme von 75342 berechnet als ›7 + 5 + 3 + 4 + 2 = 21‹, und da 21 durch 3 teilbar ist, ist auch 75342 durch 3 teilbar). Ein anderes Beispiel ist die Zahl 6, die mit der Summe ihrer Teiler identisch ist ›6 = 1 · 2 · 3 = 1 + 2 + 3‹. So lassen sich für jede Zahl spezifische Eigenschaften erkennen. Jeder, der von Mathematik begeistert ist, ist von Zahlenspielereien und Gedanken über die Besonderheiten der einzelnen Zahlen fasziniert (thaumazein, in einem altertümlichen Ausdruck ‘verwundert’) und hat seine Lieblingszahlen und Zahlen, die irgendwie fremd wirken. Auch wenn es ein Außenstehender vielleicht kaum nachvollziehen kann, zeigt sich für mich in dieser Art mit Zahlen zu spielen die gleiche Haltung und spontane Freude wie beim Kanon-Singen. Aus der Schule von Piaget stammt das Beispiel: Ich sage eine Zahl und du sagst eine Zahl. Wer die größere Zahl gesagt hat, hat gewonnen. Beide müssen lachen, wenn sie den Trick verstehen, warum ständig der zweite gewinnt, und wiederholen doch voller Übermut das gleiche Spiel immer neu. Das ist für mich das erste und einfachste Beispiel einer arithmetischen Beweisidee, mit der die Kinder ohne es wissen eine Prozedur für den Beweis gefunden haben, dass es unendlich viele Zahlen gibt.

Im Ergebnis entstehen Regeln wie die sogenannten Eselsbrücken, die jeweils für bestimmte Zahlen gelten und nicht auf andere Zahlen übertragbar sind. Jeder wird seine favorisierten Rechenverfahren haben, die ihm besonders gut gelingen, vergleichbar den Lieblingsfarben. Spencer-Brown will zu diesem ursprünglichen (naiven, magischen) Umgang mit den Zahlen zurück, denn nur aus ihm heraus ergeben sich für ihn die Möglichkeiten, den im 20. Jahrhundert entstandenen formalen Umgang mit Zahlen in einem neuen Licht zu sehen.

Im Sinne von Piaget gehört für ihn die Arithmetik zur II. Phase des symbolischen und vorbegrifflichen Denkens, die er in ihrer Besonderheit und Eigenheit erhalten will. Der Übergang zur Algebra wird daher in Vielem den Übergang zum operationalen Rechnen in der III. Phase (im Alter von 7 bis 12 Jahren) ähneln.

– Innerhalb der Arithmetik gibt es Sätze (Theoreme). Theoreme sind für Spencer-Brown Ideen, die an individuellen, einzigartigen Elementen gefunden werden. In ihnen zeigt sich die Mathematik im engeren (eigentlichen) Sinn. Die Algebra wird dagegen formuliert für Variable unabhängig von der Individualität der jeweils in die Variablen eingesetzten Werte. Daher kann die Proto-Arithmetik für Spencer-Brown keine Theoreme formal aus den Axiomen ableiten, sondern nur intuitiv erfassen und erst im zweiten Schritt mit formalen Methoden nachweisen und Konsequenzen ziehen. Dagegen kann die Vorgehensweise der Algebra im Prinzip von Computern übernommen werden. Im 20. Jahrhundert wird seit Mathematikern wie Russell die Mathematik mit der algebraischen Art zu operieren gleichgesetzt. Das ist für Spencer-Brown ein großer Rückschritt, der die Mathematik, die mathematischen Fähigkeiten und die Freude an der Mathematik verkümmern lässt.

Was mit Theoremen gemeint ist, wird am besten klar an dem von Spencer-Brown genannten Beispiel: Euklid hat den Satz bewiesen, dass es unendlich viele Primzahlen gibt. Sein Beweis war: Wenn es nur endlich viele Primzahlen gibt, gibt es eine größte Primzahl. Sie heiße N. Wird das Produkt aller Primzahlen von 1 bis N gebildet, ergibt sich ›M = 1 · 2 · 3 · 5 · 7 · 11 · …· N‹. Für M lässt sich zeigen, dass ›M + 1‹ eine Primzahl ist. Daher gibt es eine weitere Primzahl, die größer als N ist, und so fort. Diese Idee kann nicht als Konsequenz aus den arithmetischen Regeln gefolgert werden, sondern sie musste gefunden werden. Wichtig ist für Spencer-Brown zweierlei: Der Beweis zeigt sowohl eine originelle Beweisidee wie auch ein Verfahren (procedure), mit dem die Beweisidee vorgeführt wird. Die meisten werden erst vom Verfahren überzeugt sein, warum der Satz richtig ist, und von ihm ausgehend die Beweisidee verstehen. Eine solche Beweisidee ergibt sich aus der für die Arithmetik typischen Art des Rechnens, die ein tiefes Verständnis (um nicht zu sagen Mitgefühl) mit den Zahlen und ihren inneren Rhythmen und unendlich vielfältigen Beziehungen und Verwandtschaften hat. Das kann kein Computer. Computer liefern dagegen eine andere Art von Erkenntnissen, die für Spencer-Brown zur Algebra gehören.

– Spencer-Brown war von der Schalt-Algebra und der Booleschen Algebra ausgegangen und hatte die Arithmetik gesucht, die ihr vorausgeht und deren Algebra sie ist. Gewöhnlich lernen wir die Arithmetik anhand der natürlichen und reellen Zahlen kennen und anschließend all die algebraischen Regeln, wie mit ihnen gerechnet wird. George Boole (1815-1864) hatte 1847 eine vereinfachte Algebra gefunden, die mit den elementaren logischen Operationen wie UND und ODER rechnet und deren Variablen im einfachsten Fall nur für die zwei Zahlen 0 und 1 (oder in der Schalt-Algebra für ‘an’ und ‘aus’) stehen. Das war für Spencer-Brown der Ausgangspunkt, und er wollte auf diesem Weg noch einen Schritt weiter gehen: So wie die Arithmetik der natürlichen und reellen Zahlen den komplexen Theorien der Zahlentheorie und der Analysis zugrunde liegt, sollte es möglich sein, für die Boolesche Algebra eine eigene vereinfachte Arithmetik zu finden, die nur für die Zahlen 0 und 1 formuliert ist. Sie geht als primary arithmetic (Proto-Arithmetik) der üblichen Arithmetik ebenso voraus wie die Boolesche Algebra der gewöhnlichen Algebra. Auf diesem Weg ist ihm im Ergebnis eine Arithmetik gelungen, deren Zeichenvorrat mit den beiden Zeichen ⃧ und Ock noch weiter eingeschränkt ist, und die daher auch der Booleschen Algebra vorausgeht.

– Aus Sicht von Spencer-Brown können die bahnbrechenden Aussagen von Gödel anders und neu gelesen werden: Kurt Gödel (1906-1978) hat 1931 gezeigt, dass die Algebra ab einer bestimmten Komplexität der Zahlen nicht mehr alles zu sagen vermag, was in der ihr vorausgehenden Arithmetik möglich ist. Die Arithmetik enthält mit der Individualität ihrer Zeichen einen Überschuss, der von keiner Algebra vollständig erfasst und eingefangen werden kann. Die Algebra ist gegenüber der Arithmetik grundsätzlich unvollständig. Wie weit auch die Algebra entwickelt sein mag, aus der Arithmetik und dem unendlichen Vorrat ihrer jeweils individuellen Zahlen können neue Erkenntnisse kommen, die über die jeweils bekannte Algebra hinausgehen. – Wenn Spencer-Brown in Kapitel 9 von der Completeness (Vollständigkeit) spricht, meint er etwas anderes. Theorem 17 besagt: »The primary algebra is complete« (LoF, 50). Das besagt jedoch nicht, dass sie alles enthält, was an arithmetischen Entdeckungen gewonnen werden kann, sondern nur, dass jede arithmetische Entdeckung sich auch algebraisch formulieren lässt. »That is to say, if α = β can be proved as a theorem about the primary arithmetic, than it can be demonstrated as a consequence for all α, β in the primary algebra.« (LoF, 50) Mit Bedacht spricht Spencer-Brown daher von einem Theorem und nicht von einer Konsequenz, d.h. von einer Aussage, die mit den Methoden der Arithmetik und nicht mit denen der Algebra zu beweisen ist.

»So, to find the arithmetic of the algebra of logic, as it is called, is to find the constant of which the algebra is an exposition of the variables--no more, no less. Not, just to find the constants, because that would be, in terms of arithmetic of numbers, only to find the number. But to find out how they combine, and how they relate -- and that is the arithmetic. So in finding -- I think for the first time, I don't think it was found before, I haven't found it -- the arithmetic to the algebra of logic -- or better, since logic is not necessary to the algebra, in finding the arithmetic to Boolean algebra, all I did was to seek and find a) the constants, and b) how they perform.« (AUM, Session Two)

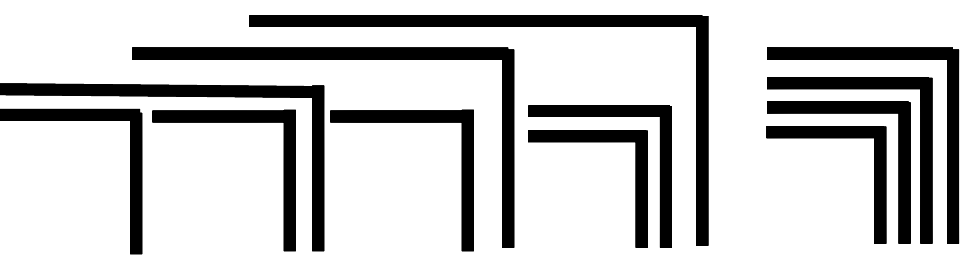

– Ein Beispiel für das Rechnen und Beweisen aus der Proto-Arithmetik

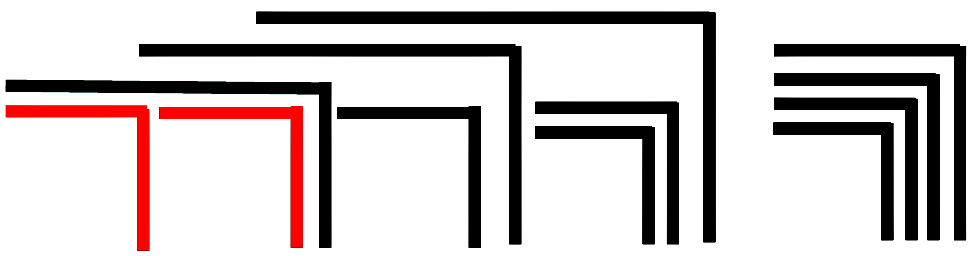

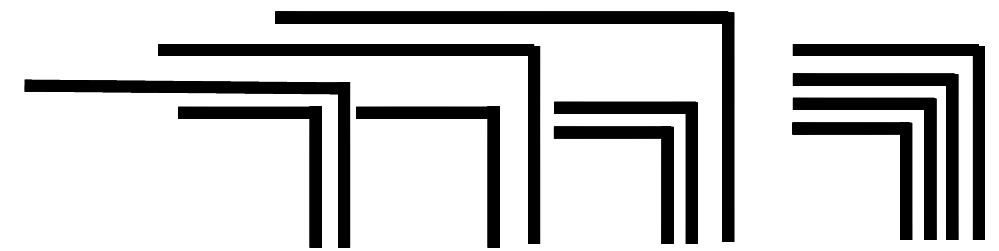

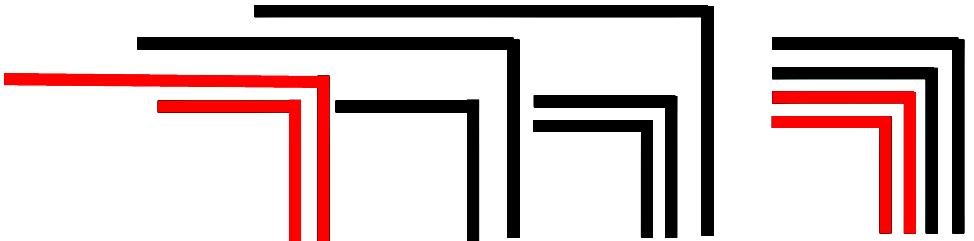

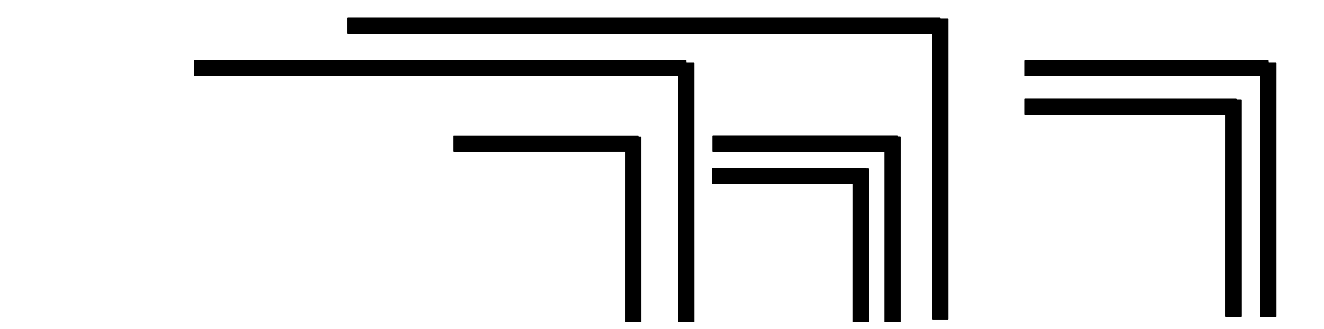

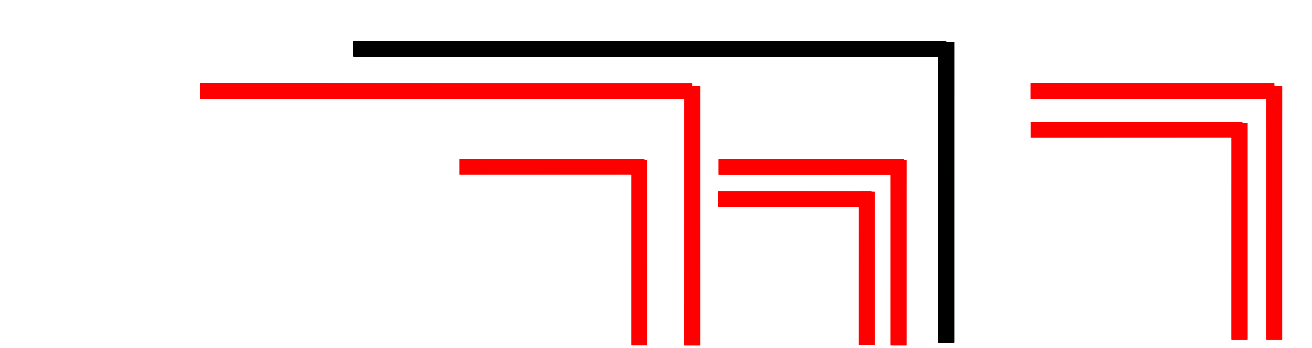

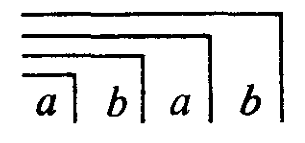

»Theorem 1. Form The form of any finite cardinal number of crosses can be taken as the form of an expression.« (LoF, 12) »Die Form jeder endlichen ganzen Zahl von Kreuzen kann als Form eines Ausdrucks aufgefasst werden.« (Spencer-Brown, übersetzt bei Lau, 68) Die Aussage ist in dieser Wortwahl kaum direkt zu verstehen. Sie bedeutet, dass eine beliebige Form, die aus endlich vielen Haken und Ocks konstruiert ist, entweder in einen einzigen Haken oder in ein einziges Ock umgewandelt werden kann. Diese Aussage kann auch anders formuliert werden: Jede noch so komplizierte aus Haken und Ocks zusammengesetzte Form kann im Ganzen als eine Form angesehen werden. Das lässt sich an einem Beispiel verdeutlichen, das Spencer-Brown später für das 3. Theorem anführt (LoF, 17):

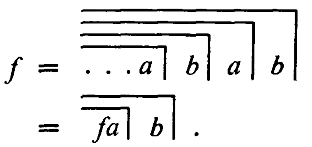

Es soll gezeigt werden, wie diese Figur auf einen Haken oder ein Ock reduziert werden kann. Die Beweisidee besteht darin, auf die tiefste Verschachtelungsstufe zu gehen. Dort gibt es nur zwei Möglichkeiten: Entweder wiederholt sich ein Haken mehrfach, oder zwei Haken sind ineinander geschachtelt. Wenn es sich wiederholt, kann es nach Axiom 1 in einen einzigen Haken zusammengefasst werden (condensation). Wenn sich zwei Haken verschachteln, können diese nach Axiom 2 in ein Ock umgewandelt werden (cancellation). Das Beispiel gibt zugleich einen Eindruck, wie in der Proto-Arithmetik gerechnet wird. Mit rot sind jeweils die Haken hervorgehoben, die im nächsten Schritt zusammengezogen oder ausgelöscht werden können. Für die Umwandlungen wird das von Spencer-Brown eingeführte Zeichen ⇀ verwendet.

Wie wichtig dies Ergebnis ist, zeigt ein Vergleich mit Netzwerken. Wenn ein unübersichtliches Netzwerk vorliegt und auf ähnliche Weise vereinfacht werden soll, können Deadlocks auftreten, bei denen jede weitere Vereinfachung blockiert ist, siehe als Beispiel die Möglichkeit von Deadlocks in Petri-Netzen. Das ist in dem von Spencer-Brown gewählten Kalkül nicht möglich. Jedes komplexe Zeichen lässt sich bis auf eins der beiden Grundzeichen umwandeln.

– Nachfolger-Relation

Der wesentliche Unterschied zwischen der Proto-Arithmetik bei Spencer-Brown und der üblichen Arithmetik liegt in der Nachfolger-Relation (successor ordinal) und der auf sie gründenden vollständigen Induktion (mathematical induction). Für alle natürlichen Zahlen n gilt die Eigenschaft, dass sie einen Nachfolger n + 1 hat. Daraus ergibt sich, dass die natürlichen Zahlen auf der Zahlengerade angeordnet werden können. Mehrfaches Ausführen der Nachfolger-Relation führt zum Addieren, und daraus ergeben sich die weiteren Rechenoperationen und mit ihnen die Erweiterungen der natürlichen Zahlen durch die negativen und rationalen Zahlen usf. Das Induktions-Axiom besagt: Wenn eine Aussage A für ein Anfangselement n0 gilt (Induktionsanfang, base case) und gezeigt werden kann, dass sie von A(n) auf A(n + 1) gefolgert werden kann (Induktionsschritt, induction step), dann gilt sie für alle natürlichen Zahlen.

Spencer-Brown stellt jedoch nicht einmal die Frage nach der Anordnung aller Zeichen der Proto-Arithmetik. In einem ersten Versuch können die aus den Wiederholungen der Haken entstehenden Zeichen angeordnet werden wie die Striche auf einem Bierdeckel:

|, ||, |||, …

⃧ , ⃧ ⃧ , ⃧ ⃧ ⃧ , …

Aber es gibt auch die Verschachtelung des Crossing. Während sich die Multiplikation und die höheren Rechenoperationen schrittweise auf die Addition zurückführen lassen, ist es nicht möglich, die Verschachtelung aus der Wiederholung herzuleiten. Beide sind unabhängig. Stattdessen bietet sich an, für die Anordnung aller in der Proto-Arithmetik betrachteten Zeichen eine lexikographische (kanonische) Ordnung wie für zwei voneinander unabhängige Buchstaben a und b zu wählen:

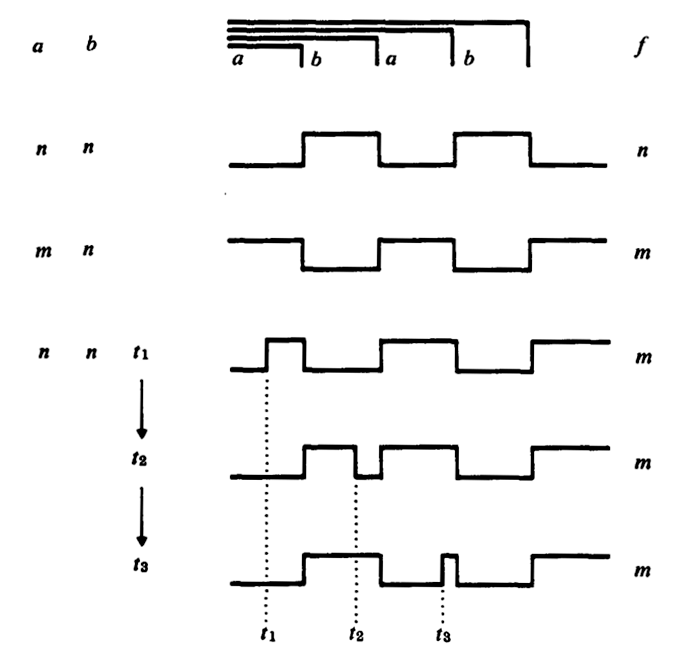

a, b, aa, ab, bb, ba, aaa, aab, …